Backend-Entwicklung

Backend-Entwicklung

Python-Tutorial

Python-Tutorial

Was ist ein Python-Crawler? Warum wird Python Crawler genannt?

Was ist ein Python-Crawler? Warum wird Python Crawler genannt?

Heute erkl?ren wir die grundlegenden konzeptionellen Kenntnisse von Python. Viele Freunde, die neu in Python sind, haben viele Fragen: Was ist ein Python-Crawler? Warum wird Python dann Crawler genannt?

Was ist ein Python-Crawler?

Bevor wir den Artikel betreten, müssen wir zun?chst wissen, was ein Crawler ist. Ein Crawler, also ein Webcrawler, kann als eine Spinne verstanden werden, die im Internet kriecht. Das Internet wird mit einem gro?en Netz verglichen, und ein Crawler ist eine Spinne, die in diesem Netz herumkriecht, wenn sie auf ihre Beute trifft ), dann wird es es packen. Wenn es beispielsweise eine Webseite crawlt und einen Pfad in dieser Webseite findet, bei dem es sich tats?chlich um einen Hyperlink handelt, der auf die Webseite verweist, kann es zu einer anderen Webseite crawlen, um Daten abzurufen. Wenn es nicht leicht zu verstehen ist, k?nnen Sie es anhand der folgenden Bilder tats?chlich verstehen:

Aufgrund der Skriptfunktionen von Python Die Verarbeitung von Zeichen ist in Python ebenfalls sehr flexibel und verfügt über umfangreiche Web-Crawling-Module, sodass beide h?ufig miteinander verknüpft sind. Python-Crawler-Entwicklungsingenieure beginnen auf einer bestimmten Seite der Website (normalerweise der Homepage), lesen den Inhalt der Webseite, finden andere Linkadressen auf der Webseite und finden dann über diese Linkadressen die n?chste Webseite wird so lange fortgesetzt, bis alle Webseiten der Website gecrawlt wurden. Betrachtet man das gesamte Internet als Website, dann k?nnen Webspider dieses Prinzip nutzen, um alle Webseiten im Internet zu crawlen.

Crawler kann den Inhalt einer Website oder einer Anwendung crawlen und nützlichen Wert extrahieren. Es kann auch Benutzervorg?nge in Browsern oder App-Anwendungen simulieren, um automatisierte Verfahren zu implementieren. Die folgenden Verhaltensweisen k?nnen mit Crawlern erreicht werden:

Vote Grabbing Artifact

Voting Artifact

Prediction (Stock Marktprognose, Kassenprognose)

Nationale Stimmungsanalyse

Soziale Beziehungsnetzwerke

Wie oben erw?hnt, k?nnen wir davon ausgehen, dass

Crawler sich im Allgemeinen auf das Crawlen von Netzwerken beziehen Ressourcen und weil die Skriptfunktionen von Python nicht nur einfach zu konfigurieren, sondern auch sehr flexibel in der Zeichenverarbeitung sind. Darüber hinaus verfügt Python über umfangreiche Web-Crawling-Module, sodass beide h?ufig miteinander verknüpft sind. Aus diesem Grund wird Python als Crawler bezeichnet.

Warum wird Python Crawler genannt? Als Programmiersprache ist Python wegen seiner pr?gnanten und klaren Syntax und der erzwungenen Verwendung von Leerzeichen zum Einrücken von Anweisungen sehr beliebt. Um ein Beispiel zu nennen: Um eine Aufgabe zu erledigen, müssen insgesamt 1.000 Codezeilen in der Sprache C, 100 Codezeilen in Java und nur 20 Codezeilen in Python geschrieben werden. Wenn Sie Python zum Ausführen von Programmieraufgaben verwenden, schreiben Sie weniger Code und der Code ist pr?ziser, kürzer und besser lesbar. Wenn ein Team entwickelt, kann es den Code anderer Personen schneller lesen und die Entwicklungseffizienz verbessern h?her, was die Arbeit effizienter macht.

Dies ist eine Programmiersprache, die sich sehr gut für die Entwicklung von Webcrawlern eignet. Im Vergleich zu anderen statischen Programmiersprachen ist die Schnittstelle von Python zum Crawlen von Webdokumenten im Vergleich zu anderen dynamischen Skriptsprachen einfacher. Das urllib2-Paket von Python bietet eine relativ einfache M?glichkeit vollst?ndige API für den Zugriff auf Webdokumente. Darüber hinaus gibt es in Python hervorragende Pakete von Drittanbietern, die das Crawlen von Webseiten effizient implementieren und die Tag-Filterfunktion von Webseiten mit sehr kurzen Codes vervollst?ndigen k?nnen.

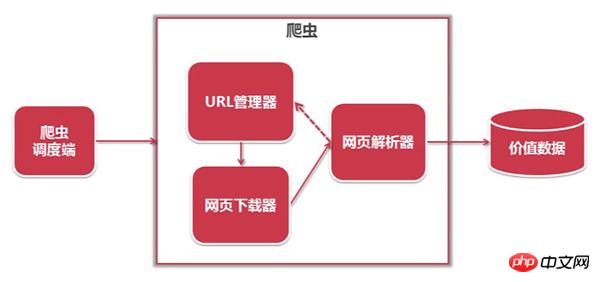

Die Architektur des Python-Crawlers ist wie folgt:

3. Analysiert wertvolle Daten, speichert sie und fügt die URL dem URL-Manager hinzu.

Der Workflow von Python ist wie folgt:

(Der Python-Crawler ermittelt, ob eine URL zum Crawlen vorhanden ist Manager: Wenn eine URL gecrawlt werden muss, wird sie über den Planer an den Downloader übergeben, der URL-Inhalt wird heruntergeladen und über den Planer an den Parser gesendet, der URL-Inhalt wird analysiert und die Wertdaten und die neue URL werden aufgelistet werden über den Scheduler an die Anwendung übergeben und der Wert wird ausgegeben Informationsprozess )

Python ist eine Programmiersprache, die sich sehr gut für die Entwicklung von Webcrawlern eignet. Sie bietet Module wie urllib, re, json, pyquery usw. und verfügt auch über viele etablierte Frameworks wie das Scrapy-Framework und das PySpider-Crawler-System. usw., was an sich sehr einfach und praktisch ist, daher ist es die bevorzugte Programmiersprache für Webcrawler. Ich hoffe, dieser Artikel kann Freunden, die gerade mit der Python-Sprache in Berührung gekommen sind, etwas helfen!

Das obige ist der detaillierte Inhalt vonWas ist ein Python-Crawler? Warum wird Python Crawler genannt?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Hei?e KI -Werkzeuge

Undress AI Tool

Ausziehbilder kostenlos

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem v?llig kostenlosen KI-Gesichtstausch-Tool aus!

Hei?er Artikel

Hei?e Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Wie man mit der API -Authentifizierung in Python umgeht

Jul 13, 2025 am 02:22 AM

Wie man mit der API -Authentifizierung in Python umgeht

Jul 13, 2025 am 02:22 AM

Der Schlüssel zum Umgang mit der API -Authentifizierung besteht darin, die Authentifizierungsmethode korrekt zu verstehen und zu verwenden. 1. Apikey ist die einfachste Authentifizierungsmethode, die normalerweise in den Anforderungsheader- oder URL -Parametern platziert ist. 2. BasicAuth verwendet Benutzername und Kennwort für die Basis64 -Codierungsübertragung, die für interne Systeme geeignet ist. 3.. OAuth2 muss das Token zuerst über Client_id und Client_secret erhalten und dann das BearerToken in den Anforderungsheader bringen. V. Kurz gesagt, die Auswahl der entsprechenden Methode gem?? dem Dokument und das sichere Speichern der Schlüsselinformationen ist der Schlüssel.

Wie man über zwei Listen gleichzeitig python iteriert

Jul 09, 2025 am 01:13 AM

Wie man über zwei Listen gleichzeitig python iteriert

Jul 09, 2025 am 01:13 AM

Eine gemeinsame Methode, um zwei Listen gleichzeitig in Python zu durchqueren, besteht darin, die Funktion ZIP () zu verwenden, die mehrere Listen in der Reihenfolge und die kürzeste ist. Wenn die Listenl?nge inkonsistent ist, k?nnen Sie iTertools.zip_longest () verwenden, um die l?ngste zu sein und die fehlenden Werte auszufüllen. In Kombination mit Enumerate () k?nnen Sie den Index gleichzeitig erhalten. 1.zip () ist pr?gnant und praktisch, geeignet für die Iteration gepaarte Daten; 2.zip_longest () kann den Standardwert beim Umgang mit inkonsistenten L?ngen einfüllen. 3.Enumerate (ZIP ()) kann w?hrend des Durchlaufens Indizes erhalten und die Bedürfnisse einer Vielzahl komplexer Szenarien erfüllen.

Was sind Python -Iteratoren?

Jul 08, 2025 am 02:56 AM

Was sind Python -Iteratoren?

Jul 08, 2025 am 02:56 AM

INPYTHON, ITERATORATORSAROBJECTSHATALWOULOUPING ThroughCollections Byimplementing__iter __ () und __Next __ (). 1) IteratorsworkviATheiterProtocol, verwendete __iter __ () toreturn thiteratorand__Next __ () torethentexteemtemuntemuntilstoperationSaised.2) und

Python Fastapi Tutorial

Jul 12, 2025 am 02:42 AM

Python Fastapi Tutorial

Jul 12, 2025 am 02:42 AM

Um moderne und effiziente APIs mit Python zu schaffen, wird Fastapi empfohlen. Es basiert auf Eingabeaufforderungen an Standardpython -Typ und kann automatisch Dokumente mit ausgezeichneter Leistung generieren. Nach der Installation von Fastapi und ASGI Server Uvicorn k?nnen Sie Schnittstellencode schreiben. Durch das Definieren von Routen, das Schreiben von Verarbeitungsfunktionen und die Rückgabe von Daten kann schnell APIs erstellt werden. Fastapi unterstützt eine Vielzahl von HTTP -Methoden und bietet automatisch generierte Swaggerui- und Redoc -Dokumentationssysteme. URL -Parameter k?nnen durch Pfaddefinition erfasst werden, w?hrend Abfrageparameter durch Einstellen von Standardwerten für Funktionsparameter implementiert werden k?nnen. Der rationale Einsatz pydantischer Modelle kann dazu beitragen, die Entwicklungseffizienz und Genauigkeit zu verbessern.

Wie man eine API mit Python testet

Jul 12, 2025 am 02:47 AM

Wie man eine API mit Python testet

Jul 12, 2025 am 02:47 AM

Um die API zu testen, müssen Sie Pythons Anfragebibliothek verwenden. In den Schritten werden die Bibliothek installiert, Anfragen gesendet, Antworten überprüfen, Zeitüberschreitungen festlegen und erneut werden. Installieren Sie zun?chst die Bibliothek über PipinstallRequests. Verwenden Sie dann Requests.get () oder Requests.Post () und andere Methoden zum Senden von GET- oder Post -Anfragen. überprüfen Sie dann die Antwort. Fügen Sie schlie?lich Zeitüberschreitungsparameter hinzu, um die Zeitüberschreitungszeit festzulegen, und kombinieren Sie die Wiederholungsbibliothek, um eine automatische Wiederholung zu erreichen, um die Stabilit?t zu verbessern.

Python variabler Umfang in Funktionen

Jul 12, 2025 am 02:49 AM

Python variabler Umfang in Funktionen

Jul 12, 2025 am 02:49 AM

In Python sind Variablen, die in einer Funktion definiert sind, lokale Variablen und sind nur innerhalb der Funktion gültig. Extern definiert sind globale Variablen, die überall gelesen werden k?nnen. 1. lokale Variablen werden zerst?rt, wenn die Funktion ausgeführt wird. 2. Die Funktion kann auf globale Variablen zugreifen, kann jedoch nicht direkt ge?ndert werden, sodass das globale Schlüsselwort erforderlich ist. 3. Wenn Sie die ?u?eren Funktionsvariablen in verschachtelten Funktionen ?ndern m?chten, müssen Sie das nichtlokale Schlüsselwort verwenden. 4.. Variablen mit demselben Namen beeinflussen sich in verschiedenen Bereichen nicht gegenseitig; 5. Global muss bei der Modifizierung globaler Variablen deklariert werden, ansonsten werden ungebundener Fehler aufgeworfen. Das Verst?ndnis dieser Regeln hilft bei der Vermeidung von Fehler und zum Schreiben zuverl?ssigerer Funktionen.

Wie man eine HTML -Tabelle mit Python und Pandas analysiert

Jul 10, 2025 pm 01:39 PM

Wie man eine HTML -Tabelle mit Python und Pandas analysiert

Jul 10, 2025 pm 01:39 PM

Ja, Sie k?nnen HTML -Tabellen mit Python und Pandas analysieren. Verwenden Sie zun?chst die Funktion pandas.read_html (), um die Tabelle zu extrahieren, mit der HTML -Elemente in einer Webseite oder in einer String in eine DataFrame -Liste analysiert werden k?nnen. Wenn die Tabelle dann keinen klaren Spalten -Titel hat, kann sie behoben werden, indem die Header -Parameter angegeben oder das Attribut für Columns manuell festgelegt werden. Für komplexe Seiten k?nnen Sie die Anfragebibliothek kombinieren, um HTML -Inhalte zu erhalten, oder die BeautifulSoup verwenden, um bestimmte Tabellen zu lokalisieren. Achten Sie auf gemeinsame Fallstricke wie JavaScript-Rendering, Codierungsprobleme und Multi-Table-Erkennung.

Zugang zu verschachtelten JSON -Objekt in Python

Jul 11, 2025 am 02:36 AM

Zugang zu verschachtelten JSON -Objekt in Python

Jul 11, 2025 am 02:36 AM

Der Weg zum Zugang zu verschachtelten JSON -Objekten in Python besteht darin, zuerst die Struktur zu kl?ren und dann Schicht für Schicht zu indexieren. Best?tigen Sie zun?chst die hierarchische Beziehung von JSON, wie ein W?rterbuch verschachtelter W?rterbuch oder Liste; Verwenden Sie dann W?rterbuchschlüssel und Listenindex, um auf Ebene für Schicht zuzugreifen, z. B. Daten "Details" ["Zip"], um die ZIP -Codierung zu erhalten, Daten "Details" [0], um das erste Hobby zu erhalten. Um KeyError und IndexError zu vermeiden, kann der Standardwert durch die Methode .get () festgelegt werden, oder die Kapselungsfunktion Safe_get kann verwendet werden, um einen sicheren Zugriff zu erzielen. Für komplexe Strukturen suchen Sie rekursiv oder verwenden Sie Bibliotheken von Drittanbietern wie JMespath.