Périphériques technologiques

Périphériques technologiques

IA

IA

Utilisation de SLM sur LLM pour une résolution de problèmes efficace - Analytics Vidhya

Utilisation de SLM sur LLM pour une résolution de problèmes efficace - Analytics Vidhya

Utilisation de SLM sur LLM pour une résolution de problèmes efficace - Analytics Vidhya

Apr 27, 2025 am 09:27 AMrésumé:

- Le modèle de petit langage (SLM) est con?u pour l'efficacité. Ils sont meilleurs que le modèle de grande langue (LLM) dans des environnements déficientes en ressources, en temps réel et sensibles à la confidentialité.

- Le meilleur pour les taches basées sur la mise au point, en particulier lorsque la spécificité du domaine, la contr?labilité et l'interprétabilité sont plus importantes que les connaissances générales ou la créativité.

- Les SLM ne remplacent pas les LLM, mais ils sont idéaux lorsque la précision, la vitesse et la rentabilité sont essentielles.

La technologie nous aide à réaliser plus avec moins de ressources. Il a toujours été un promoteur, pas un chauffeur. De l'ère de la machine à vapeur à l'ère des bulles Internet, la puissance de la technologie se situe dans la mesure où elle nous aide à résoudre des problèmes. L'intelligence artificielle (IA) et plus récemment l'IA génératrice ne font pas exception! Si les modèles traditionnels d'apprentissage automatique sont les mieux adaptés à une tache, il n'est pas nécessaire d'utiliser des modèles d'apprentissage en profondeur que nous ne pouvons pas encore expliquer leur sortie. Il en va de même pour les modèles de grande langue (LLM). Plus grand ne signifie pas mieux. Cet article vous aidera à déterminer quand utiliser un modèle de petit langage (SLM) au lieu d'un modèle grand langage (LLM) dans une déclaration de problème spécifique.

Table des matières

- Les facteurs principaux stimulent la sélection SLM

- Limitations des ressources

- Retard et exigences en temps réel

- Spécificité du domaine et efficacité de réglage fin

- Prévisibilité et contr?le

- Interprétabilité et débogage

- études de cas et exemples pratiques

- Systèmes intégrés et Internet des objets

- Automatisation des services financiers

- Outils de diagnostic médical

- Génération de code pour les plateformes de niche

- Assistant vocal localisé

- Choisissez le bon modèle: Cadre de décision

- Une vue équilibrée: limites de SLM

- en conclusion

- Questions fréquemment posées

Les facteurs principaux stimulent la sélection SLM

Les modèles de petits langues sont des outils multifonctionnels qui peuvent être appliqués à une variété de taches de traitement du langage naturel (NLP). Lorsque vous décidez d'utiliser LLM ou SLM, la question n'est pas seulement de ce que le modèle peut faire , mais ce dont le cas d'utilisation a besoin . SLM n'est pas une tentative de rivaliser avec la taille ou la polyvalence de LLM. Leurs forces réelles sont l'efficacité, la concentration et l'applicabilité contextuelle.

Voyons quels facteurs de base peuvent rendre les petits modèles de langage plus avantageux.

Limitations des ressources

Limitations matérielles:

Dans de nombreux cas, le déploiement d'un modèle sur un appareil mobile, un microcontr?leur ou un système de bord est plus que le gla?age sur le gateau - c'est la seule option viable. Dans ces environnements, tous les mégaoctets et chaque milliseconde sont cruciaux. SLM est suffisamment léger pour travailler dans ces limites tout en étant suffisamment intelligent pour offrir de la valeur.

Nous parlons de modèles qui peuvent fonctionner sur un Raspberry Pi ou un smartphone sans avoir besoin d'une connexion Internet en arrière-plan ou d'un grand GPU. Ceci est crucial pour les applications hors ligne telles que les appareils électroménagers intelligents, les appareils portables ou les systèmes intégrés dans des zones éloignées.

Exemple: traduction en temps réel sur les appareils IoT économiques dans les villages éloignés.

Sensibilité aux co?ts:

Parfois, le problème n'est pas le matériel - c'est l'échelle. Si vous traitez des millions de demandes de faible complexité par jour (comme le marquage automatique des billets de support ou la génération de résumé de base), LLM est trop lourd dans les aspects financiers et opérationnels.

SLM fournit une alternative. Vous pouvez les affiner immédiatement, les exécuter sur une infrastructure locale ou sur un GPU modeste et sauter les co?ts en cours de l'API LLM. Cela est très logique pour les outils internes, les services publics orientés avec les clients et les taches NLP répétitives à haute capacité.

Exemple: automatiser 100 000 réponses de soutien par jour sans dépasser votre budget.

Retard et exigences en temps réel

Applications clés:

Dans certains cas d'utilisation, la vitesse n'est pas un luxe - c'est une exigence difficile. Envisagez des applications inacceptables même si le retard est de 1 à 2 secondes: un drone qui re?oit des commandes vocales, un système de réalité augmenté qui réagit aux mouvements ou un assistant vocal intégré dans une voiture. Dans ces cas, les décisions se produisent en temps réel et le modèle n'a pas le temps d'effectuer des calculs lourds ou des aller-retour dans le cloud-trip.

En raison de sa petite taille et de sa complexité réduite, SLM fournit une faible inférence de latence pour les courses localement, ce qui le rend idéal pour les taches sensibles au temps qui nécessitent un temps de réponse en millisecondes.

Exemple: Expliquez immédiatement les commandes vocales (plut?t que quelques secondes plus tard) pour atterrir le drone.

Localisation:

Le retard n'est pas seulement une question de vitesse; C'est aussi une question d'indépendance. S'appuyer sur l'accès à Internet signifie l'ajout de vulnérabilités à votre application: pannes de réseau, limitations de bande passante et risques de confidentialité. En revanche, SLM peut être déployé entièrement sur l'appareil, vous permettant de vous débarrasser des contraintes de la dépendance au cloud.

Ceci est particulièrement précieux dans les domaines sensibles à la confidentialité tels que les soins de santé ou les finchs finchys, où conserver des données sur un appareil est à la fois une option de performance et une exigence de conformité.

Exemple: les kiosques de santé intelligents dans les zones éloignées, qui peuvent fonctionner même hors ligne, gérer les demandes de patients sans envoyer aucune information au cloud.

Spécificité du domaine et efficacité de réglage fin

Expertise cible:

L'une des plus grandes idées fausses sur l'IA est la croyance que les modèles plus grands signifient toujours de meilleures réponses. Mais dans la pratique, lorsque vous travaillez sur des taches spécialisées telles que le marquage des rapports médicaux, la classification des clauses contractuelles ou la génération de code de niche. Vous n'avez pas besoin de connaissances sur l'ensemble de l'Internet. Il vous suffit d'avoir une compréhension approfondie des domaines spécifiques.

Les SLM peuvent rapidement et efficacement des données spécifiques au domaine et avoir tendance à surpasser les LLM sur ces taches étroites simplement parce qu'elles sont formées sur un contenu important et rien d'autre.

Exemple: Modèles spécialement formés pour les contrats juridiques, de meilleures conditions de marquage que General LLM.

Réduire la demande de données:

La formation ou le réglage fin du LLM nécessite souvent un accès à des ensembles de données massifs et divers et une grande quantité de temps de GPU. D'un autre c?té, SLM peut rapidement effectuer des taches en utilisant des ensembles de données plus petits et plus sélectionnables, ce qui signifie une expérimentation plus rapide, des cycles de développement moins chers et moins de frais généraux autour de la gouvernance des données.

Cela profite aux startups, aux chercheurs et aux équipes internes avec des données étiquetées ou des ressources informatiques limitées.

Exemple: affinez le SLM avec 5 000 requêtes client annotées pour construire le chatbot intelligent de votre produit sans le budget de votre laboratoire de recherche.

Prévisibilité et contr?le

Cohérence de sortie:

Dans le déploiement réel, la cohérence est souvent plus précieuse que la créativité. Par exemple, si vous générez un résumé de facture, des requêtes SQL ou des manifestes de conformité, vous devez sortir précisément, plut?t que de réécrire de manière créative à chaque fois.

En raison de sa petite taille et de sa gamme de formation étroite, le comportement des SLMS a tendance à être plus certain. Lorsqu'ils sont bien affinés, ils produisent une sortie très reproductible, ce qui les rend idéales pour les cas d'utilisation qui reposent sur des formats structurés et imprimés. C'est plus qu'un simple détail technique; Dans de nombreux flux de travail d'entreprise, il s'agit d'une exigence commerciale.

En comparant cela à LLM, le LLM peut modifier légèrement son libellé entre les sessions, ou générer de longues réponses formatées irrégulières. Bien que cette variabilité puisse être utile dans le brainstorming ou les conversations naturelles, elle peut apporter des risques ou des frictions inutiles dans des environnements structurés.

Exemple: générer un résumé médical structuré ou un rapport fiscal automatique, où chaque champ a un format fixe, nécessitant un comportement prévisible fourni par le SLM.

Interprétabilité et débogage

Expliquons ces termes à tous les lecteurs:

L'interprétabilité fait référence à la capacité de comprendre pourquoi un modèle fait une prédiction ou une décision spécifique. Par exemple, quelles fonctionnalités ou exemples de formation conduisent à une sorte de classification ou de sortie?

Le débogage fait référence à la possibilité de diagnostiquer, de suivre et de réparer le mauvais comportement dans un modèle, tels que la classification erronée ou les erreurs logiques dans les réponses générées.

Ceux-ci ne sont pas facultatifs dans les workflows AI du monde réel; Ils sont cruciaux! Vous devez être en mesure de faire confiance au système, de justifier sa sortie et de dépanner rapidement.

SLM a des architectures plus petites et une formation spécifique au domaine, ce qui facilite la vérification. Vous pouvez généralement associer des prédictions de modèle à des exemples de formation spécifiques ou à des structures d'indices. Et en raison du cycle de formation plus rapide, le débogage itératif et les améliorations sont plus faciles à mettre en ?uvre même pour les petites équipes.

Exemple: Dans une demande de technologie juridique, si le SLM marque une clause contractuelle comme non conforme, les experts du domaine peuvent rapidement retracer la décision à la formation du modèle de clauses similaires, confirmer la logique et s'adapter en conséquence si nécessaire.

En revanche, le comportement d'expliquer de grands LLMS ressemble souvent à une tentative de rétro-ingénieur de l'océan.

études de cas et exemples pratiques

La théorie est grande, mais les applications du monde réel donnent vie le potentiel des modèles de petits langues (SLM). Voici cinq scénarios où les SLM sont non seulement réalisables mais les meilleurs. Ces exemples couvrent les industries et les types de problèmes, montrant comment des modèles plus petits peuvent avoir un impact sans surdose.

Systèmes intégrés et Internet des objets

Cas d'utilisation: Irrigation intelligente dans les zones agricoles éloignées .

Imaginez un système d'irrigation intelligent déployé dans une zone agricole instable. Il faut analyser les données des capteurs tels que l'humidité du sol, l'humidité et les prévisions météorologiques et générer un résumé exploitable et des informations pour les agriculteurs locaux.

Le SLM est intégré directement dans des dispositifs basés sur des capteurs pour interpréter les flux de données entrants à partir de détecteurs d'humidité, de moniteurs de température et d'API météorologiques. Au lieu de télécharger des données brutes sur le cloud, le modèle génère un résumé du langage naturel ou une recommandation de ?prochaine action? pour les agriculteurs - par exemple, ?le niveau d'irrigation est le meilleur aujourd'hui; aucune irrigation n'est requise.?

Comment SLM peut aider:

- Déployer sur un microcontr?leur (comme le processeur ARM Cortex-M)

- Réduire les frais généraux de communication et la latence

- Soutenir la prise de décision dans les zones sans Internet fiable

Ici, SLM peut être déployé directement sur les appareils Edge, expliquant les modèles et suggérant des temps d'irrigation sans compter sur des serveurs cloud. Ce n'est pas seulement une question de commodité, cela implique également le contr?le, la rentabilité et l'autonomie.

Pourquoi SLM est-il plus adapté ici?

- Exigences de consommation d'énergie extrêmement faibles

- Analyse en temps réel local

- Pas besoin d'accès continu à Internet

Ce cas d'utilisation montre comment l'IA peut évoluer vers les systèmes au niveau des infrastructures sans la charge de calcul lourde.

Automatisation des services financiers

Cas d'utilisation: classification des transactions en temps réel et alertes dans les applications bancaires de détail .

Dans le secteur financier, la cohérence et le retard sont cruciaux. Il y a peu de place pour l'ambigu?té ou l'erreur lors de la catégorisation des milliers de transactions quotidiennes, de la détection des anomalies ou de la génération automatique de courriels temporaires pour les mises à jour réglementaires.

SLM est affiné pour identifier les modèles de transaction et les classer; Par exemple, les ?services publics?, ?souscrivent?, ?dépenses commerciales?. Il signale également des anomalies qui s'écartent du comportement des utilisateurs attendus, de la génération d'alertes de modèles ou de recommandations à proximité pour le personnel de soutien.

Comment SLM peut aider:

- Traiter des milliers de requêtes simultanées en millisecondes

- Fournir une sortie fiable et structurée sans hallucination

- Faire fonctionner de manière rentable sur une infrastructure interne avec un fort sentier d'audit

Les SLM brillent ici parce qu'ils fournissent une réponse prévisible et à grande vitesse. Ils sont affinés en utilisant les données et la terminologie de votre établissement et peuvent fonctionner de manière fiable sans la surcharge (ou l'imprévisibilité) des grands LLM.

Pourquoi SLM est-il plus adapté ici?

- Temps de réponse en millisecondes

- Réduire le risque d'hallucinations ou de déviations

- Plus facile à auditer et à maintenir

Et, parce qu'ils peuvent fonctionner à une échelle rentable et à grande échelle, ils sont idéaux pour les outils internes qui nécessitent une précision plut?t que de la poésie.

Outils de diagnostic médical

Cas d'utilisation: Assistant de triage préliminaire dans une clinique locale .

Imaginez une clinique distante avec des connexions limitées et pas de serveurs cloud. Le personnel de la clinique a besoin d'une aide au triage rapide: résumer les dossiers médicaux, identifier les notes de risque et hiérarchiser les cas critiques.

Un corpus ajusté SLM de descriptions médicales et de sympt?mes médicales sélectionnées soutient les infirmières privilégiées des cas de patients. Il met en évidence les indicateurs de risque clés (par exemple, ?fièvre longue?, ?respiration courte?) et les mappe à des maladies possibles sur la base de règles cliniques prédéfinies.

Comment SLM peut aider:

- Exécuter complètement hors ligne - aucune donnée de patient ne laisse les locaux

- Maintenir la cohérence du langage médical et de la terminologie

- Parce que le comportement est interprétable, il est plus facile d'authentifier et de prouver

Le déploiement de grands modèles ici n'est pas possible. Cependant, un SLM bien formé (hébergé sur l'infrastructure locale) peut fournir ce support sans exposer les données sensibles des patients aux systèmes externes.

Pourquoi SLM est-il plus adapté ici?

- Prend en charge les déploiements locaux de la confidentialité

- Vocabulaire médical affiné dans des domaines spécifiques

- Fournir des résultats cohérents et explicables

Dans les industries réglementées telles que les soins de santé, le SLM permet non seulement d'économiser des ressources, ce qui aide également à maintenir la confiance.

Génération de code pour les plateformes de niche

Cas d'utilisation: prototypage rapide du microcontr?leur Arduino ou ESP32 .

Tous les développeurs ne créent pas la prochaine application Web. Certains développeurs programmer des appareils IoT, des planches Arduino ou des microcontr?leurs de bas niveau - où la mémoire est serrée et spécifique.

Un SLM formé pour le code système intégré (par exemple, Micropython, C) aide les développeurs à générer des fonctions de configuration pour les capteurs, les boucles de commande de moteur ou les configurations de réseau. Il s'intègre directement dans l'IDE, augmentant ainsi la productivité des développeurs.

Comment SLM peut aider:

- Raisonnement plus rapide par rapport à l'assistant de code LLM

- Précision plus élevée en raison d'une formation centralisée pour une syntaxe spécifique au matériel spécifique

- Vous pouvez régulièrement recycler pour les dernières mises à jour de la plate-forme

Le SLM formé pour les bases de micropython ou C pour ces environnements peut générer des extraits syntaxiques compacts qui conviennent aux contraintes de plate-forme. De plus, comme l'espace de problème est bien défini, le modèle ne nécessite pas de milliards de paramètres pour obtenir le résultat correct.

Pourquoi SLM est-il plus adapté ici?

- Affinement fine efficace pour les zones étroites

- Prototypage rapide dans les environnements limités en matériel

- Sortie prévisible pour les plates-formes intégrées

Il s'agit d'une victoire claire pour les équipes qui apprécient la vitesse, le contr?le des plages et l'autonomie des développeurs.

Assistant vocal localisé

Cas d'utilisation: Support vocal multilingue pour les applications de gouvernance rurale .

Commen?ons par un scénario dans l'Inde rurale. L'assistant vocal multilingue aide les utilisateurs à vérifier les prévisions météorologiques, à accéder aux plans du gouvernement ou à gérer leurs calendriers, tous dans les dialectes locaux.

L'exécution de cela sur LLM signifiera les compromis de confidentialité des données et les co?ts élevés. Cependant, avec SLM, tout le traitement peut être effectué localement sur l'appareil. Il est rapide, privé et fonctionne même sans Internet.

Un slm ajusté pour les dialectes locaux et un libellé culturellement spécifique est intégré dans une application vocale sur un téléphone Android à faible co?t. Les utilisateurs peuvent poser des questions comme ?Quand la prochaine subvention de blé sera-t-elle publiée?? et recevez des réponses précises et sensibles au contexte dans leur langue, même si elles sont hors ligne.

Comment SLM peut aider:

- Ne pas compter sur le cloud ou sur Internet

- Meilleure adhésion aux réglementations du gouvernement sur la confidentialité des données

- Les nuances de zone peuvent être adaptées à travers de petits cycles de mise à jour

Pourquoi SLM est-il plus adapté ici?

- Fonction hors ligne pour les zones à faible connexion

- Respecter la confidentialité des utilisateurs en évitant la transmission des données

- Utilisez une formation dans des dialectes spécifiques pour l'acculturation

C'est là que les SLM vont au-delà des choix technologiques; Ils deviennent des ponts à la fusion numérique.

Choisissez le bon modèle: Cadre de décision

Il s'agit d'un tableau de décision simplifié qui aide à guider la sélection du modèle:

| Facteurs de décision | SLM | LLM |

|---|---|---|

| Environnement de déploiement | Appareils Edge, appareils mobiles, faible volume informatique | Serveur cloud ou haute performance |

| Budget | Strict ou limité | Niveau flexible ou en entreprise |

| Besoin de réponse en temps réel | Oui (retard de la l'impulsion) | NON OU DéTENDE INCERTABLE |

| Zone de mission | étroit, hautement spécialisé | Large ou universel |

| Confidentialité des données | Données élevées (survices ou sensibles) | Faible (acceptable pour le traitement du cloud) |

| Contr?le de sortie | Besoin d'une structure élevée et d'une cohérence | Missions créatives ou exploratoires |

| Taille de l'ensemble de données | Petits ensembles de données sélectionnés | Ensembles de données importants et diversifiés |

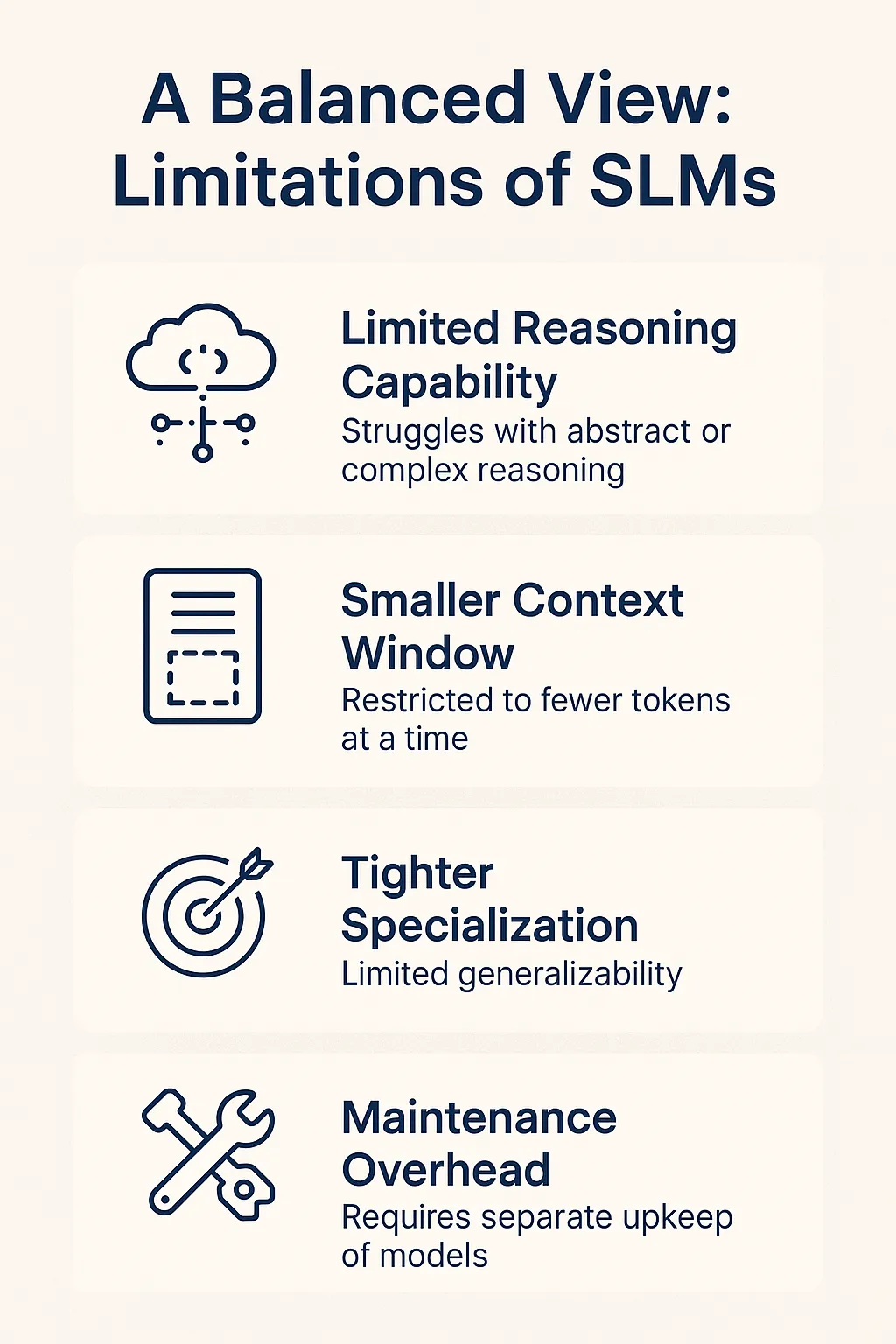

Une vue équilibrée: limites de SLM

Bien que les SLM soient de forts concurrents dans de nombreux cas d'utilisation, ils ne sont pas la panacée. Il est important de comprendre leurs compromis, en particulier lors de l'examen des déploiements de production.

- Capacité de raisonnement limité: le SLM a des capacités faibles dans le traitement du raisonnement abstrait, multi-HOP ou de synthèse longue. Si votre tache consiste à résumer 20 pages de documents juridiques ou à naviguer dans les cha?nes logiques floues, les modèles plus grands peuvent mieux fonctionner.

- La fenêtre de contexte est plus petite: de nombreux SLM ne peuvent traiter que quelques milliers de balisages à la fois, ce qui les rend inappropriés pour des documents longs, des conversations étendues ou des applications qui nécessitent des connaissances de base approfondies.

- La spécialisation est plus stricte: bien que la spécialisation soit un avantage, elle limite également l'universalité. Sans formation supplémentaire, les modèles affinés pour les billets médicaux ne fonctionnent pas bien en termes de briefings juridiques ou de revues de produits.

- Offres de maintenance: si vous avez besoin de plusieurs modèles professionnels (par exemple, pour le support client, la recherche interne et le résumé RH), vous devrez peut-être maintenir et surveiller chaque SLM séparément, et un LLM bien intégré peut gérer tous ces problèmes avec des conseils intelligents.

SLM n'essaie pas d'être un "modèle universel". Ils sont con?us pour poursuivre la précision plut?t que le pouvoir et pour poursuivre l'efficacité plut?t que l'évolutivité. Le SLM peut être le meilleur choix pour vous lorsque votre portée de problème est claire, les contraintes sont réelles et la sortie doit être fiable.

en conclusion

Le modèle de petit langage (SLM) aide à optimiser le co?t et la vitesse. Les SLM traitent des problèmes du point de vue des taches qu'ils tentent de résoudre. SLM nous amène dans une ère plus réfléchie des écosystèmes d'IA où le contexte du problème est un déterminant clé du modèle, et non de l'échelle.

La montée de SLM ne signifie pas la fin de LLM - en fait, il y a de l'espoir pour des modèles d'IA plus professionnels construits à des fins spécifiques à l'avenir, pas seulement pour se montrer.

Nous nous tournons vers SLM plus fin et open source optimisé pour les taches étroites. SLM n'est plus seulement une mini-version de LLM; Ce sont des résolveurs de problèmes pour des taches spécifiques.

Questions fréquemment posées

Q1. Quand devrais-je choisir un modèle de petit langage au lieu d'un grand modèle de langue? R. Lorsque vous avez besoin d'une faible utilisation des ressources, d'un raisonnement rapide sur les appareils ou d'une focalisation stricte au lieu de connaissances approfondies.

Q2. Le SLM peut-il vraiment fonctionner hors ligne sur des appareils tels que les téléphones mobiles ou les microcontr?leurs? A. Absolument! Le SLM est suffisamment petit pour résider sur le matériel Edge, comme un Pi ou un smartphone de framboise, et fonctionne sans Internet.

Q3. L'utilisation de SLM peut-elle économiser de l'argent par rapport à l'appel de l'API LLM? R. Oui! Une fois que vous avez un SLM affiné localement, vous pouvez ignorer les frais d'API par demande et traiter de grandes quantités de données sur une infrastructure modeste.

Q4. Comment le SLM fonctionne-t-il dans des taches de niche telles que le marquage de la clause juridique ou le résumé médical? A. SLM peut être rapidement formé sur de petits ensembles de données centralisés pour fournir une sortie précise et cohérente dans le domaine professionnel.

Q5. Que ne peut pas faire SLM comme LLM? A. Ils sont difficiles à gérer de longs documents (en raison de la plus petite durée de contexte), du raisonnement en plusieurs étapes et bénéficient d'une génération créative et ouverte de données de formation massives.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undress AI Tool

Images de déshabillage gratuites

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

échangez les visages dans n'importe quelle vidéo sans effort grace à notre outil d'échange de visage AI entièrement gratuit?!

Article chaud

Outils chauds

Bloc-notes++7.3.1

éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Kimi K2: le modèle agentique open source le plus puissant

Jul 12, 2025 am 09:16 AM

Kimi K2: le modèle agentique open source le plus puissant

Jul 12, 2025 am 09:16 AM

Rappelez-vous le flot de modèles chinois open source qui a perturbé l'industrie du Genai plus t?t cette année? Alors que Deepseek a fait la majeure partie des titres, Kimi K1.5 était l'un des noms importants de la liste. Et le modèle était assez cool.

Grok 4 vs Claude 4: Quel est le meilleur?

Jul 12, 2025 am 09:37 AM

Grok 4 vs Claude 4: Quel est le meilleur?

Jul 12, 2025 am 09:37 AM

à la mi-2025, l'AI ?Arme Race? se réchauffe, et Xai et Anthropic ont tous deux publié leurs modèles phares, Grok 4 et Claude 4.

10 robots humano?des incroyables qui marchent déjà parmi nous aujourd'hui

Jul 16, 2025 am 11:12 AM

10 robots humano?des incroyables qui marchent déjà parmi nous aujourd'hui

Jul 16, 2025 am 11:12 AM

Mais nous n'aurons probablement pas à attendre même 10 ans pour en voir un. En fait, ce qui pourrait être considéré comme la première vague de machines vraiment utiles, de type humain, est déjà là. Les dernières années ont vu un certain nombre de prototypes et de modèles de production sortant de T

L'ingénierie contextuelle est la & # 039; New & # 039; Ingénierie rapide

Jul 12, 2025 am 09:33 AM

L'ingénierie contextuelle est la & # 039; New & # 039; Ingénierie rapide

Jul 12, 2025 am 09:33 AM

Jusqu'à l'année précédente, l'ingénierie rapide était considérée comme une compétence cruciale pour interagir avec les modèles de langage grand (LLM). Récemment, cependant, les LLM ont considérablement progressé dans leurs capacités de raisonnement et de compréhension. Naturellement, nos attentes

L'application mobile d'immersité de Leia apporte une profondeur 3D aux photos de tous les jours

Jul 09, 2025 am 11:17 AM

L'application mobile d'immersité de Leia apporte une profondeur 3D aux photos de tous les jours

Jul 09, 2025 am 11:17 AM

Construit sur le moteur de profondeur neuronale propriétaire de Leia, l'application traite des images fixes et ajoute de la profondeur naturelle avec un mouvement simulé - comme les casseroles, les zooms et les effets de parallaxe - pour créer de courts bobines vidéo qui donnent l'impression de pénétrer dans le SCE

Quels sont les 7 types d'agents d'IA?

Jul 11, 2025 am 11:08 AM

Quels sont les 7 types d'agents d'IA?

Jul 11, 2025 am 11:08 AM

Imaginez quelque chose de sophistiqué, comme un moteur d'IA prêt à donner des commentaires détaillés sur une nouvelle collection de vêtements de Milan, ou une analyse de marché automatique pour une entreprise opérant dans le monde entier, ou des systèmes intelligents gérant une grande flotte de véhicules.

Ces modèles d'IA n'ont pas appris la langue, ils ont appris la stratégie

Jul 09, 2025 am 11:16 AM

Ces modèles d'IA n'ont pas appris la langue, ils ont appris la stratégie

Jul 09, 2025 am 11:16 AM

Une nouvelle étude de chercheurs du King’s College de Londres et de l’Université d’Oxford partage les résultats de ce qui s'est passé lorsque Openai, Google et Anthropic ont été jetés ensemble dans un concours fardé basé sur le dilemme du prisonnier itéré. Ce n'était pas

Crise de commandement dissimulé: les chercheurs jeu aiment être publiés

Jul 13, 2025 am 11:08 AM

Crise de commandement dissimulé: les chercheurs jeu aiment être publiés

Jul 13, 2025 am 11:08 AM

Les scientifiques ont découvert une méthode intelligente mais alarmante pour contourner le système. Juillet 2025 a marqué la découverte d'une stratégie élaborée où les chercheurs ont inséré des instructions invisibles dans leurs soumissions académiques - ces directives secrètes étaient la queue