Peranti teknologi

Peranti teknologi

AI

AI

5 juta token raksasa, baca keseluruhan 'Harry Potter' sekali gus! Lebih daripada 1000 kali lebih lama daripada ChatGPT

5 juta token raksasa, baca keseluruhan 'Harry Potter' sekali gus! Lebih daripada 1000 kali lebih lama daripada ChatGPT

5 juta token raksasa, baca keseluruhan 'Harry Potter' sekali gus! Lebih daripada 1000 kali lebih lama daripada ChatGPT

Jun 10, 2023 am 10:42 AMMemori yang lemah ialah titik kesakitan utama model bahasa berskala besar semasa Contohnya, ChatGPT hanya boleh memasukkan 4096 token (kira-kira 3000 perkataan saya sering lupa apa yang saya katakan sebelum ini, dan memang begitu tidak cukup untuk membaca cerpen.

Tetingkap input pendek juga mengehadkan senario aplikasi model bahasa Contohnya, apabila meringkaskan kertas saintifik (kira-kira 10,000 patah perkataan), artikel itu perlu dibahagikan secara manual adalah input ke dalam model, maklumat yang berkaitan antara bab yang berbeza hilang.

Walaupun GPT-4 menyokong sehingga 32,000 token dan Claude yang dinaik taraf menyokong sehingga 100,000 token, mereka hanya boleh mengurangkan masalah kapasiti otak yang tidak mencukupi.

Baru-baru ini pasukan keusahawanan Magic mengumumkan bahawa ia tidak lama lagi akan mengeluarkan model LTM-1, yang boleh menyokong sehingga 5 juta token Ia adalah kira-kira 500,000 baris kod atau 5,000 fail, iaitu 50 kali lebih tinggi daripada Claude pada asasnya boleh menampung kebanyakan keperluan storan Ini benar-benar perubahan kuantitatif.

Senario aplikasi utama LTM-1 ialah pelengkapan kod, contohnya, ia boleh menjana cadangan kod yang lebih panjang dan lebih kompleks.

Anda juga boleh menggunakan semula dan mensintesis maklumat merentas berbilang fail.

Berita buruknya ialah Magic, pembangun LTM-1, tidak mengeluarkan prinsip teknikal khusus, tetapi hanya mengatakan bahawa ia mereka bentuk kaedah baharu Rangkaian Memori Jangka Panjang (LTM Net).

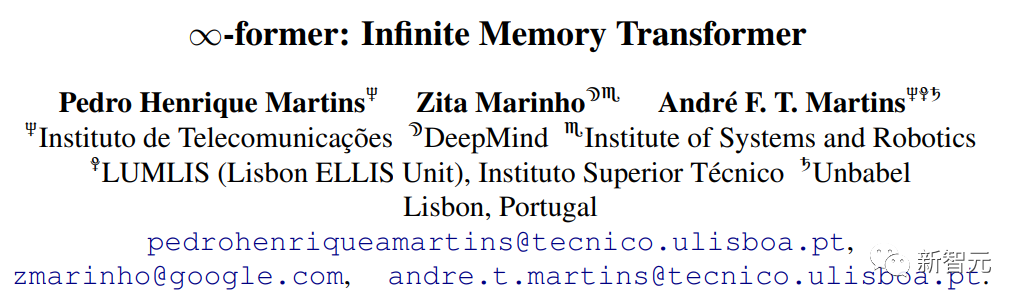

Tetapi terdapat juga berita baik pada September 2021, penyelidik dari DeepMind dan institusi lain mencadangkan model yang dipanggil ∞-bekas, yang merangkumi ingatan jangka panjang (ingatan jangka panjang (LTM). ) mekanisme, yang secara teorinya membenarkan model Transformer mempunyai memori yang tidak terhingga, tetapi pada masa ini tidak jelas sama ada kedua-duanya adalah teknologi yang sama atau versi yang lebih baik.

Pautan kertas: https://arxiv.org/pdf/2109.00301.pdf

Pasukan pembangunan menyatakan bahawa walaupun LTM Nets boleh melihat lebih banyak konteks daripada GPT, bilangan parameter model LTM-1 jauh lebih kecil daripada model sota semasa, jadi ia lebih pintar . Rendah, tetapi terus meningkatkan saiz model akan meningkatkan prestasi LTM Nets.

Pada masa ini LTM-1 telah membuka aplikasi ujian alfa.

Pautan aplikasi: https://www.php. cn/link/bbfb937a66597d9646ad992009aee405

Magic, pembangun LTM-1, diasaskan pada 2022. Ia terutamanya membangunkan produk yang serupa dengan GitHub jurutera menulis dan menyemak, menyahpepijat dan mengubah suai kod, matlamatnya adalah untuk mencipta rakan sekerja AI untuk pengaturcara yang kelebihan daya saing utamanya ialah model boleh membaca kod yang lebih panjang.

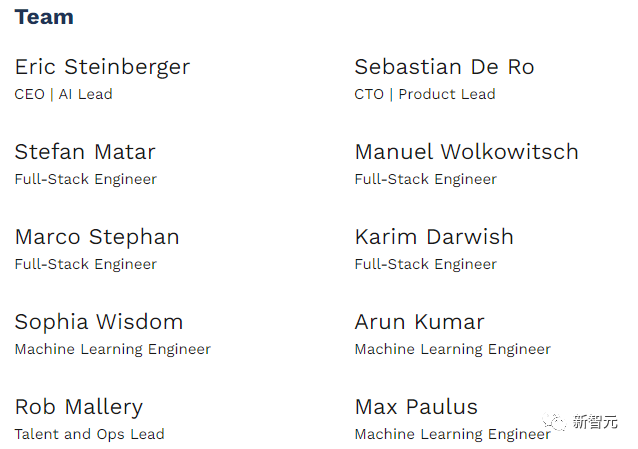

Magic komited untuk manfaat awam, dan misinya adalah untuk membina dan menggunakan sistem AGI dengan selamat yang melebihi keupayaan manusia Ia kini merupakan syarikat permulaan dengan hanya 10 orang.

Pada Februari tahun ini, Magic menerima AS$23 juta dalam pembiayaan Siri A yang diketuai oleh CapitalG, anak syarikat Alphabet. Pelabur juga Termasuk Nat Friedman, bekas Ketua Pegawai Eksekutif GitHub dan pengeluar bersama Copilot, jumlah pembiayaan syarikat kini mencecah AS$28 juta.

Eric Steinberger, Ketua Pegawai Eksekutif dan pengasas bersama Magic, lulus dari Universiti Cambridge dengan ijazah sarjana muda dalam sains komputer dan telah melakukan penyelidikan pembelajaran mesin di FAIR.

Sebelum mengasaskan Magic, Steinberger juga mengasaskan ClimateScience untuk membantu kanak-kanak di seluruh dunia mengetahui tentang kesan perubahan iklim.

Pengubah ingatan tak terhingga

Reka bentuk mekanisme perhatian dalam Transformer, komponen teras model bahasa, akan menyebabkan kerumitan masa meningkat setiap kali panjang daripada jujukan input meningkat.

Walaupun sudah terdapat beberapa varian mekanisme perhatian, seperti perhatian yang jarang, dll. untuk mengurangkan kerumitan algoritma, kerumitannya masih berkaitan dengan panjang input dan tidak boleh berkembang tidak terhingga.

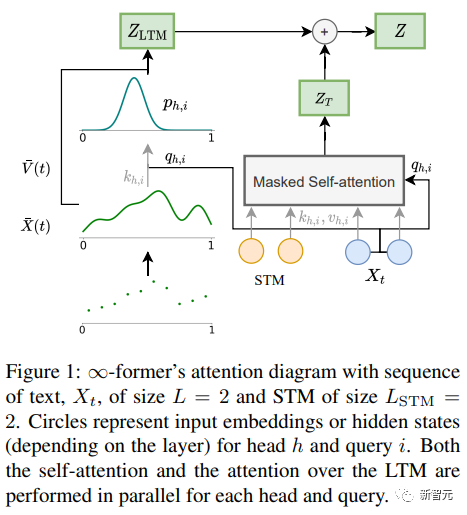

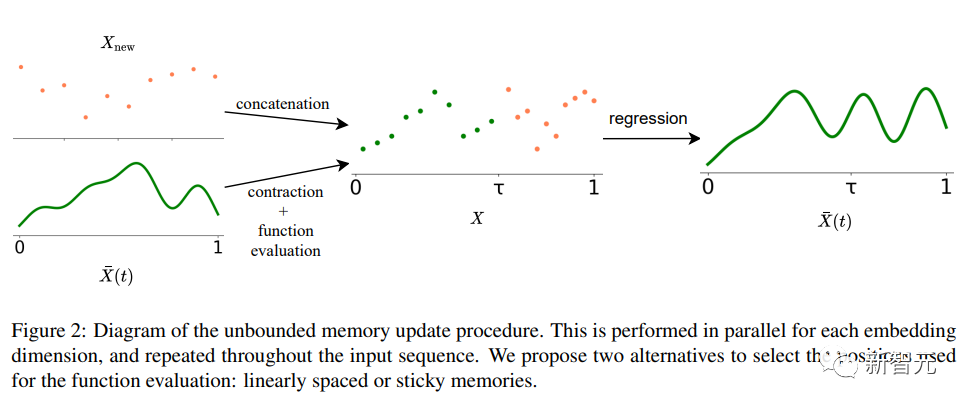

∞-bekas Kunci kepada model Transformer ingatan jangka panjang (LTM) yang boleh memanjangkan urutan input kepada infiniti ialah rangka kerja perhatian spatial berterusan yang mengurangkan kebutiran perwakilan Meningkatkan bilangan unit maklumat ingatan (fungsi asas).

Dalam rangka kerja, jujukan input diwakili sebagai "isyarat berterusan", mewakili N fungsi asas jejari ( RBF ), dengan cara ini, kerumitan perhatian ∞-bekas dikurangkan kepada O(L^2 + L × N), manakala kerumitan perhatian Transformer asal ialah O(L×(L+L_LTM)) , di mana L dan L_LTM sepadan dengan saiz input Transformer dan panjang ingatan jangka panjang masing-masing.

Kaedah perwakilan ini mempunyai dua kelebihan utama:

1 Konteks boleh diwakili oleh fungsi asas N yang lebih kecil daripada nombor daripada token, mengurangkan Kos pengiraan perhatian dikurangkan;

Sudah tentu, tiada makan tengah hari percuma, dan harganya ialah pengurangan resolusi: apabila menggunakan nombor yang lebih kecil fungsi asas, Boleh mengakibatkan pengurangan ketepatan apabila mewakili urutan input sebagai isyarat berterusan.

Sudah tentu, tiada makan tengah hari percuma, dan harganya ialah pengurangan resolusi: apabila menggunakan nombor yang lebih kecil fungsi asas, Boleh mengakibatkan pengurangan ketepatan apabila mewakili urutan input sebagai isyarat berterusan.

Untuk mengurangkan masalah pengurangan resolusi, penyelidik memperkenalkan konsep "kenangan melekit", yang mengaitkan ruang yang lebih besar dalam isyarat LTM kepada kawasan memori yang lebih kerap diakses , mencipta konsep "kekal " dalam LTM, yang membolehkan model menangkap latar belakang jangka panjang dengan lebih baik tanpa kehilangan maklumat yang relevan, dan juga diilhamkan oleh potensi jangka panjang dan keplastikan otak.

Bahagian eksperimen

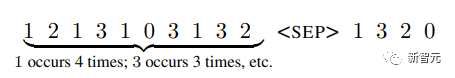

Untuk mengesahkan sama ada ∞-bekas boleh memodelkan konteks yang panjang, penyelidik pertama Eksperimen adalah dijalankan pada tugas sintesis menyusun token mengikut kekerapan dalam urutan yang panjang; kemudian eksperimen dijalankan ke atas pemodelan bahasa dan penjanaan dialog berasaskan dokumen dengan menyempurnakan model bahasa yang telah dilatih.

Isih

Input terdiri daripada token yang disampel mengikut taburan kebarangkalian ( tidak diketahui oleh sistem), matlamatnya adalah untuk menjana token mengikut urutan penurunan kekerapan dalam jujukan

mengikut urutan untuk mengkaji sama ada memori jangka panjang digunakan dengan berkesan, dan Transformer Sama ada ranking dilakukan hanya dengan memodelkan teg terkini, penyelidik mereka bentuk taburan kebarangkalian tag untuk berubah dari semasa ke semasa.

mengikut urutan untuk mengkaji sama ada memori jangka panjang digunakan dengan berkesan, dan Transformer Sama ada ranking dilakukan hanya dengan memodelkan teg terkini, penyelidik mereka bentuk taburan kebarangkalian tag untuk berubah dari semasa ke semasa.

Terdapat 20 token dalam perbendaharaan kata Eksperimen telah dijalankan dengan urutan panjang masing-masing 4,000, 8,000 dan 16,000 dan pengubah mampatan digunakan sebagai model garis dasar.

Hasil eksperimen dapat dilihat bahawa dalam kes panjang jujukan pendek (4,000), Transformer-XL mencapai ketepatan lebih tinggi sedikit daripada model lain tetapi apabila panjang jujukan meningkat, ketepatannya juga menurun dengan cepat, tetapi Untuk ∞-dahulu, penurunan ini tidak jelas, menunjukkan bahawa ia mempunyai lebih banyak kelebihan apabila memodelkan jujukan panjang.

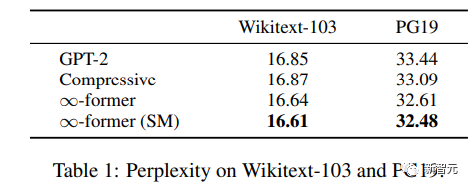

Pemodelan Bahasa

Untuk memahami sama ada ingatan jangka panjang boleh digunakan untuk melanjutkan pra-latihan Untuk model bahasa, penyelidik memperhalusi GPT-2 kecil pada subset Wikitext103 dan PG-19, termasuk kira-kira 200 juta token.

Hasil eksperimen dapat dilihat bahawa ∞-bekas dapat mengurangkan kekeliruan Wikitext-103 dan PG19, dan ∞ - Peningkatan yang diperoleh oleh bekas adalah lebih besar pada set data PG19 kerana buku lebih bergantung pada ingatan jangka panjang berbanding artikel Wikipedia.

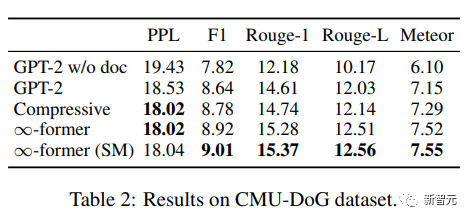

Dialog berasaskan dokumen

Dalam penjanaan dialog berasaskan dokumen, kecuali Sebagai tambahan kepada sejarah perbualan, model juga boleh mendapatkan dokumen tentang topik perbualan.

Dalam set data CMU Document Grounded Conversation (CMU-DoG), perbualan adalah mengenai filem dan ringkasan filem diberikan sebagai dokumen tambahan memandangkan perbualan itu mengandungi pelbagai berbeza Dalam wacana berterusan, dokumen tambahan dibahagikan kepada bahagian.

Untuk menilai kegunaan ingatan jangka panjang, penyelidik menjadikan tugasan lebih mencabar dengan hanya memberikan model akses kepada fail sebelum perbualan bermula.

Selepas menala halus GPT-2 kecil, untuk membolehkan model menyimpan keseluruhan dokumen dalam ingatan, LTM berterusan (∞-bekas) dengan fungsi asas N=512 adalah digunakan untuk memanjangkan GPT -2.

Untuk menilai kesan model, gunakan kebingungan, skor F1, Rouge-1 dan Rouge-L serta penunjuk Meteor.

Daripada keputusan, ∞-bekas dan mampatan Transformer boleh menjana korpus yang lebih baik, walaupun kekeliruan antara kedua-dua Darjah pada asasnya adalah sama, tetapi ∞-bekas mencapai skor yang lebih baik pada penunjuk lain.

Atas ialah kandungan terperinci 5 juta token raksasa, baca keseluruhan 'Harry Potter' sekali gus! Lebih daripada 1000 kali lebih lama daripada ChatGPT. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undress AI Tool

Gambar buka pakaian secara percuma

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Apa itu Ethereum? Apakah cara untuk mendapatkan Ethereum Eth?

Jul 31, 2025 pm 11:00 PM

Apa itu Ethereum? Apakah cara untuk mendapatkan Ethereum Eth?

Jul 31, 2025 pm 11:00 PM

Ethereum adalah platform aplikasi yang terdesentralisasi berdasarkan kontrak pintar, dan ETH token asalnya boleh diperolehi dalam pelbagai cara. 1. Daftar akaun melalui platform berpusat seperti Binance dan Ouyiok, pensijilan KYC lengkap dan membeli ETH dengan stablecoins; 2. Sambungkan ke penyimpanan digital melalui platform yang terdesentralisasi, dan secara langsung bertukar ETH dengan stablecoins atau token lain; 3. Mengambil bahagian dalam ikrar rangkaian, dan anda boleh memilih Ikrar Bebas (memerlukan 32 ETH), perkhidmatan ikrar cecair atau ikrar satu klik pada platform terpusat untuk mendapatkan ganjaran; 4. Dapatkan ETH dengan menyediakan perkhidmatan kepada projek Web3, menyelesaikan tugas atau mendapatkan udara. Adalah disyorkan bahawa pemula bermula dari platform terpusat arus perdana, beransur -ansur beralih ke kaedah yang terdesentralisasi, dan selalu melampirkan kepentingan keselamatan aset dan penyelidikan bebas, ke

Ethereum Shines: Bank of America Memulakan Penjejakan Aset Digital, ETH menjadi tumpuan lagi

Aug 01, 2025 pm 08:09 PM

Ethereum Shines: Bank of America Memulakan Penjejakan Aset Digital, ETH menjadi tumpuan lagi

Aug 01, 2025 pm 08:09 PM

Bank of America memulakan penjejakan aset digital untuk menandakan peningkatan pengiktirafan Ethereum dalam kewangan arus perdana. 1. Peningkatan pengiktirafan kesahihan; 2. Ia boleh menarik institusi untuk memperuntukkan aset digital; 3. Menggalakkan proses pematuhan; 4. Sahkan prospek aplikasi dan nilai berpotensi ETH sebagai "minyak digital"; Ethereum telah menjadi tumpuan kerana ekosistem Dapp yang besar, 1. Meningkatkan teknologi kepada PO untuk meningkatkan skalabiliti, keselamatan dan kemampanan; 2. Pinjaman sokongan, perdagangan dan perkhidmatan kewangan lain sebagai teras DEFI; 3. Menyokong kemakmuran NFT dan menyatukan permintaan ekologi; 4. Memperluas aplikasi peringkat perusahaan seperti pengurusan rantaian bekalan; 5. EIP-1559 memperkenalkan mekanisme deflasi untuk meningkatkan kekurangan; Platform perdagangan teratas termasuk: 1. Binance (Volume Trading)

Ramalan Harga Fartcoin (Fartcoin) 2025-2030: Berapakah jumlah harga yang akan dicapai pada masa akan datang?

Jul 31, 2025 pm 08:39 PM

Ramalan Harga Fartcoin (Fartcoin) 2025-2030: Berapakah jumlah harga yang akan dicapai pada masa akan datang?

Jul 31, 2025 pm 08:39 PM

Direktori Apa itu Fartcoin (Fartcoin)? Prestasi Pasaran: Pemandu Teras Harga Perubahan Harga Harga Harga Roller Coaster untuk Hari Ini, Besok dan 30 Hari Seterusnya Fartcoin (Fartcoin) 2025-2030 Ramalan Harga Fartcoin (Fartcoin) 2025 Ramalan Harga Bulanan untuk 2026 Fartcoin (Fartcoin) Ramalan Harga (Fartcoin) untuk ramalan harga fartcoin (fartcoin) 2029 untuk 2030 fartcoin (FA

App Exchange OUYI Versi Android V6.132.0 OUYI App Rasmi Laman Web Muat turun dan Panduan Pemasangan 2025

Aug 04, 2025 pm 11:18 PM

App Exchange OUYI Versi Android V6.132.0 OUYI App Rasmi Laman Web Muat turun dan Panduan Pemasangan 2025

Aug 04, 2025 pm 11:18 PM

OKX adalah platform perkhidmatan aset digital yang terkenal di dunia, menyediakan pengguna dengan produk dan perkhidmatan yang pelbagai termasuk tempat, kontrak, pilihan, dan lain-lain. Dengan pengalaman operasi yang lancar dan integrasi fungsi yang kuat, aplikasi rasminya telah menjadi alat yang sama untuk banyak pengguna aset digital.

Kedudukan terkini Platform Perdagangan Sepuluh Bitcoin Teratas di Dunia

Aug 01, 2025 pm 07:36 PM

Kedudukan terkini Platform Perdagangan Sepuluh Bitcoin Teratas di Dunia

Aug 01, 2025 pm 07:36 PM

1. Binance adalah platform utama dengan jumlah perdagangan global. Ia terkenal dengan mata wangnya yang kaya, model perdagangan yang pelbagai dan perkhidmatan pembiayaan pelancaran. Ia mempunyai susun atur global yang luas; 2. Okx terkenal dengan derivatif kewangan yang inovatif dan keselamatan yang tinggi, dan secara aktif menggunakan ekosistem Web3; 3.gate.io mempunyai sejarah yang panjang dan menyediakan lebih daripada 1,000 urus niaga mata wang, dengan sistem yang stabil dan kawalan risiko yang ketat; 4. Huobi menyediakan perkhidmatan perdagangan yang pelbagai, kekuatan penyelidikan yang kuat, dan memberi perhatian kepada pematuhan dan keselamatan; 5. Kucoin dikenali sebagai "Platform Perdagangan Kebangsaan", menarik pelabur dengan yuran yang rendah dan projek berpotensi pulangan yang tinggi, dan mempunyai respons perkhidmatan pelanggan yang cepat; 6. Kraken adalah pertukaran Amerika yang terkenal dengan langkah-langkah keselamatan yang ketat, menyokong urus niaga mata wang fiat, dan mempunyai pematuhan yang tinggi; 7. Bitstamp adalah platform veteran Eropah, berkhidmat

Kumpulan Ant boleh bekerjasama dengan Circle untuk memperkenalkan USDC ke rantai semut

Aug 01, 2025 pm 07:15 PM

Kumpulan Ant boleh bekerjasama dengan Circle untuk memperkenalkan USDC ke rantai semut

Aug 01, 2025 pm 07:15 PM

Ant Group sedang berunding dengan Circle untuk memperkenalkan USDC ke dalam rantaian semut, 1. Meningkatkan kecekapan pembayaran rentas sempadan dan melayani perusahaan kecil dan sederhana ekologi Alibaba; 2. Membina Jambatan Ekologi Defi dan meneroka kewangan yang terputus -putus; 3. Menggalakkan susun atur pematuhan global dan membantu Alipay memperluaskan pasaran Eropah, Amerika dan Tenggara Asia. Walaupun menghadapi sekatan pengawalseliaan China dan persaingan sengit, langkah ini masih menandakan satu kejayaan penting bagi gergasi teknologi Cina dalam globalisasi kewangan blockchain, yang menunjukkan bahawa perusahaan tradisional mempercepatkan aset kripto yang mematuhi mereka.

Gergasi Wall Street telah meletakkan stablecoins, dan bank tradisional telah melancarkan 'perang pertahanan' untuk pembayaran

Aug 01, 2025 pm 07:21 PM

Gergasi Wall Street telah meletakkan stablecoins, dan bank tradisional telah melancarkan 'perang pertahanan' untuk pembayaran

Aug 01, 2025 pm 07:21 PM

Wall Street secara aktif menggunakan stablecoins untuk mengatasi perubahan dalam medan pembayaran. 1. Cagaran mata wang fiat, 2. Motivasi susun atur bank termasuk meningkatkan kecekapan pembayaran rentas sempadan, memperluaskan sempadan perkhidmatan, bertindak balas terhadap tekanan kompetitif, memenuhi keperluan institusi dan meneroka CBDC; JPMorgan Chase JPM Coin, Citi Citi Token, Fidelity dan Goldman Sachs, dan lain -lain menunjukkan bahawa kewangan tradisional telah menganggapnya sebagai infrastruktur kritikal; Menghadapi cabaran pembayaran bukan bank dan gergasi teknologi, bank mengamalkan strategi seperti merangkul teknologi, membina ekosistem, meningkatkan pengalaman, memanfaatkan kelebihan pematuhan dan mengambil bahagian dalam CBDC; Pada masa akan datang, pengawasan akan mengukuhkan audit rizab, pengurusan lesen, perlindungan pengguna, pematuhan AML/CFT dan koordinasi global untuk mempromosikan integrasi stablecoin

Beli stablecoins, menganalisis semua langkah

Aug 01, 2025 pm 07:30 PM

Beli stablecoins, menganalisis semua langkah

Aug 01, 2025 pm 07:30 PM

Langkah -langkah untuk membeli stablecoins adalah: 1. Pilih platform perdagangan yang bereputasi, seperti pertukaran berpusat seperti Binance, Huobi, OKX, Coinbase, atau pertukaran yang terdesentralisasi seperti Uniswap dan Pancakeswap. Anda juga boleh membelinya melalui laman web rasmi penerbit USDT, USDC, DAI, dan lain -lain; 2. Daftar akaun dan lengkap pengesahan identiti KYC, sediakan kad ID atau pasport dan dokumen lain, dan sediakan pengesahan dua faktor (2FA) untuk meningkatkan keselamatan akaun; 3. Mengikat akaun bank atau kad kredit, pilih pemindahan bank, pembayaran kad kredit atau pembayaran pihak ketiga dan kaedah lain untuk mendepositkan mata wang fiat, dan sahkan kadar pertukaran dan yuran pengendalian dan cas semula lengkap; 4. Masukkan antara muka urus niaga untuk memilih "Transaksi Filipina" atau "Koin Beli Pantas", dan pilih jenis stablecoin yang diperlukan seperti