In der jüngsten Welt der Technologieentwicklung und des maschinellen Lernens ist es nicht mehr in der Mikro -Cloud, sondern in mobilen Ger?ten eingeschlossen. Wie wir wissen, sind TensorFlow Lite und Pytorch Mobile zwei der im Handel erh?ltlichen Tools zum Bereitstellen von Modellen direkt auf Telefonen und Tablets. Tensorflow Lite und Pytorch Mobile sind beide entwickelt, um auf Mobilger?ten zu arbeiten, aber sie stehen in ihren Vor- und Nachteilen unterschiedlich. Hier in diesem Artikel sollen wir wissen, was Tensorflow Lite ist, was Pytorch Mobile ist, ihre Anwendungen und Unterschiede zwischen beiden.

Lernergebnisse

- überblick über das maschinelle Lernen von Ger?ten und warum es eher vorteilhaft als Cloud -basierte Systeme ist.

- Erfahren Sie mehr über TensorFlow Lite und Pytorch Mobile, das für die Bereitstellung mobiler Anwendungen verwendet wird.

- So konvertieren Sie geschulte Modelle für die Bereitstellung mithilfe von Tensorflow Lite und Pytorch Mobile.

- Vergleichen Sie die Leistung, die Benutzerfreundlichkeit und die Plattformkompatibilit?t von TensorFlow Lite und Pytorch Mobile.

- Implementieren Sie Beispiele für maschinelles Lernen von On-Device-Lernen mit TensorFlow Lite und Pytorch Mobile.

Dieser Artikel wurde als Teil des Data Science -Blogathons ver?ffentlicht.

Inhaltsverzeichnis

- Was macht maschinelles Lernen im Einsatz?

- Erkundung von Tensorflow Lite

- Pytorch Mobile Implementierung

- Leistungsvergleich: Tensorflow Lite gegen Pytorch Mobile

- Benutzerfreundlichkeit und Entwicklererfahrung

- Unterstützte Plattformen und Ger?tekompatibilit?t

- Modellkonvertierung: Vom Training bis zum Einsatz

- Anwendungsf?lle für Tensorflow Lite und Pytorch Mobile

- Tensorflow Lite Implementierung

- Pytorch Mobile Implementierung

- Abschluss

- H?ufig gestellte Fragen

Was macht maschinelles Lernen im Einsatz?

Wir k?nnen KI auf den mobilen Ger?ten wie Smartphone, Tablet oder einem anderen Ger?t mit maschinellem Lernen ausführen. Wir müssen uns nicht auf Dienste von Wolken verlassen. Dies sind eine schnelle Reaktion, die Sicherheit sensibler Informationen, und die Anwendung kann mit oder ohne Internetkonnektivit?t ausgeführt werden, die für verschiedene Anwendungen sehr wichtig sind. Bilderkennung in Echtzeit, maschineller übersetzung und Augmented Reality.

Erkundung von Tensorflow Lite

TensorFlow Lite ist die Tensorflow -Version, die h?ufig auf Ger?ten mit eingeschr?nkten Funktionen verwendet wird. Es funktioniert und ist mit anderen Betriebssystemen wie dem Android und dem iPhone kompatibel. Es konzentriert sich haupts?chlich in die Bereitstellung von Latenz- und Hochleistungsausführung. Bei TensorFlow Lite gibt es einen Modelloptimierer, mit dem bestimmte Methoden beispielsweise die Quantisierung auf Modelle angewendet werden k?nnen. Dies macht Modelle schneller und kleiner für die mobile Bereitstellung, was in dieser Praxis unerl?sslich ist, um die Effizienz zu verbessern.

Merkmale von Tensorflow Lite

Im Folgenden finden Sie einige wichtigste Merkmale von TensorFlow Lite:

- Small Binary Size : TensorFlow Lite binaries can be of very small size. Es kann bis zu 300 KB sein.

- Hardware Acceleration : TFLite supports GPU and other hardware accelerators via delegates, such as Android's NNAPI and iOS's CoreML.

- Model Quantization : TFLite offers many different quantization methods to optimize performance and reduce model size without sacrificing too much accuracy.

Pytorch Mobile Implementierung

Pytorch Mobile ist die mobile Erweiterung von Pytorch. Es ist allgemein bekannt für seine Flexibilit?t in der Forschung und Produktion. Pytorch Mobile erleichtert einfach, ein geschultes Modell aus einer Desktop -Umgebung zu nehmen und es ohne viel ?nderung auf mobilen Ger?ten bereitzustellen. Es konzentriert sich mehr auf die Benutzerfreundlichkeit des Entwicklers, indem es dynamische Berechnungsdiagramme unterstützt und das Debuggen erleichtert.

Funktionen von Pytorch Mobile

Im Folgenden finden Sie einige wichtige Merkmale von Pytorch Mobile:

- Pre-built Models : PyTorch Mobile provides a large range of pre-trained models that can be converted to run on mobile devices.

- Dynamic Graphs : It is one of PyTorch's dynamic computation graphs that allow for flexibility during development.

- Custom Operators : PyTorch Mobile allows us to create custom operators, which can be useful for advanced use cases.

Leistungsvergleich: Tensorflow Lite gegen Pytorch Mobile

Wenn wir ihre Leistung diskutieren, sind beide Frameworks für mobile Ger?te optimiert, TensorFlow Lite hat jedoch eine hohe Ausführungsgeschwindigkeit und Ressourceneffizienz.

- Execution Speed : TensorFlow Lite is generally faster due to its aggressive optimization, such as quantization and delegate-based acceleration. Zum Beispiel-NNAPI und GPU.

- Binary Size : TensorFlow Lite has a smaller footprint, with binary sizes as low as 300KB for minimal builds. Pytorch Mobile Binaries sind in der Regel gr??er und erfordern mehr Feinabstimmungen für eine leichte Bereitstellung.

Benutzerfreundlichkeit und Entwicklererfahrung

Pytorch Mobile wird aufgrund seiner Flexibilit?t und einfachen Debugging im Allgemeinen von Entwicklern bevorzugt. Es liegt an dynamischen Berechnungsgraphen. Dies hilft uns, Modelle zur Laufzeit zu modifizieren, was sich hervorragend für Prototypen eignet. Andererseits erfordert TensorFlow Lite vor dem Einsatz in ein statisches Format umgewandelt, was Komplexit?t verleihen kann, aber zu optimierteren Modellen für Mobilger?te führen kann.

- Model Conversion : PyTorch Mobile allows us for direct export of PyTorch models, while TensorFlow Lite requires converting TensorFlow models using the TFLite Converter.

- Debugging : PyTorch's dynamic graph makes it easier to debug models while they're running, which is great for spotting issues quickly. Mit dem statischen Diagramm von TensorFlow Lite kann das Debuggen etwas schwierig sein, obwohl TensorFlow Tools wie Model Analyzer bietet, die uns helfen k?nnen.

Unterstützte Plattformen und Ger?tekompatibilit?t

Wir k?nnen sowohl Tensorflow Lite als auch Pytorch Mobile auf zwei wichtigen mobilen Plattformen, Android und iOS, verwenden.

Tensorflow Lite

Wenn es darum geht, welche Hardware unterstützt wird, ist Tflite viel flexibler. Aufgrund des Delegiertensystems unterstützt es nicht nur CPUs und GPUs, sondern auch digitale Signalprozessoren (DSPs) und andere Chips, die als h?here Künstler angesehen werden als die Basis -CPUs.

Pytorch Mobile

W?hrend Pytorch Mobile auch CPUs und GPUs wie Metal für iOS und Vulkan für Android unterstützt, bietet es über dies hinaus weniger Optionen für die Beschleunigung der Hardware. Dies bedeutet, dass Tflite m?glicherweise den Vorteil hat, wenn wir eine breitere Hardwarekompatibilit?t ben?tigen, insbesondere für Ger?te mit spezialisierten Prozessoren.

Modellkonvertierung: Vom Training bis zum Einsatz

Der Hauptunterschied zwischen Tensorflow Lite und Pytorch Mobile besteht darin, wie Modelle von der Trainingsphase auf mobile Ger?te eingesetzt werden.

Tensorflow Lite

Wenn wir ein TensorFlow -Modell auf Mobilger?ten bereitstellen m?chten, muss es mit dem TFLite -Konverter konvertiert werden. Dieser Prozess kann optimiert werden, z. B. Quantisierung, die das Modell für mobile Ziele schnell und effizient macht.

Pytorch Mobile

Für Pytorch Mobile k?nnen wir das Modell mit TorchScript speichern. Der Prozess ist sehr einfacher und einfach, bietet jedoch nicht das gleiche Niveau an erweiterten Optimierungsoptionen, die Tflite bereitstellt.

Anwendungsf?lle für Tensorflow Lite und Pytorch Mobile

Entdecken Sie die realen Anwendungen von Tensorflow Lite und Pytorch Mobile und zeigen Sie, wie diese Rahmenbedingungen intelligente L?sungen in verschiedenen Branchen betreiben.

Tensorflow Lite

Tflite ist eine bessere Plattform für verschiedene Anwendungen, die schnelle Antworten erfordern, wie z. B. Echtzeit-Bildklassifizierung oder Objekterkennung. Wenn wir an Ger?ten mit speziellen Hardware wie GPUs oder neuronalen Verarbeitungseinheiten arbeiten. Die Hardware -Beschleunigungsfunktionen von Tflite helfen dem Modell schneller und effizienter.

Pytorch Mobile

Pytorch Mobile eignet sich hervorragend für Projekte, die sich noch weiterentwickeln, wie Forschung oder Prototyp -Apps. Seine Flexibilit?t erleichtert es einfach zu experimentieren und zu iterieren, was es den Entwicklern erm?glicht, schnelle ?nderungen vorzunehmen. Pytorch Mobile ist ideal, wenn wir h?ufig neue Modelle mit minimalen Modifikationen experimentieren und bereitstellen müssen.

Tensorflow Lite Implementierung

Wir werden ein vorgebildetes Modell (Mobilenetv2) verwenden und es in den Tensorflow Lite umwandeln.

Laden und Speichern des Modells

Das erste, was wir tun, ist den Tensorflow importieren und ein vorgebildetes Mobilenetv2-Modell laden. Es ist bereit, für die Vorausbildung im ImageNet-Datensatz zu verwenden, wie in diesem Modell zu sehen ist. Das Modell model.export ('mobilenet_model') schreibt das Modell in einem Format des SavedModel von TensorFlow. Dies ist das Format, das erforderlich ist, um es in das TensorFlow Lite -Modell (TFLite) umzuwandeln, das mit mobilen Ger?ten verwendet wird.

# Schritt 1: Richten Sie die Umgebung ein und laden Sie ein vorgebildetes Mobilenetv2-Modell

Tensorflow als TF importieren

# Laden Sie ein vorgezogenes Mobilenetv2 -Modell auf

model = tf.keras.applications.mobilenetv2 (Gewicht = 'ImagEnet', input_shape = (224, 224, 3))

# Speichern Sie das Modell als SavedModel für die Tflite -Konvertierung

model.export ('mobilenet_model')

Konvertieren Sie das Modell in den Tensorflow lite

Das Modell wird aus dem gespeicherten Modell (MOBILENET_MODEL -Verzeichnis) unter Verwendung von TFLiteConverter geladen. Der Konverter wandelt das Modell in ein leichteres .tflite -Format um. Schlie?lich wird das TFLite -Modell als mobilenet_v2.tflite für die sp?tere Verwendung in mobilen oder Kantenanwendungen gespeichert.

# Schritt 2: Konvertieren Sie das Modell in den Tensorflow Lite

Converter = tf.lite.tfliteConverter.from_saved_model ('mobilenet_model')

tflite_model = converter.convert ()

# Speichern Sie das konvertierte Modell in einer Tflite -Datei

mit open ('mobilenet_v2.tflite', 'wb') als f:

F.Write (Tflite_Model)

Laden des Tflite -Modells für Inferenz

Jetzt importieren wir die notwendigen Bibliotheken für numerische Operationen (Numpy) und Bildmanipulation (Pil.Image). Das TFLite -Modell wird unter Verwendung von tf.lite.interpreterand geladen. Der Speicher wird für Eingangs-/Ausgangstensoren zugeordnet. Wir holen Details zu den Eingangs-/Ausgabe -Tensoren wie den Formen und Datentypen ab, die nützlich sein, wenn wir das Eingabebild vorbereiten und die Ausgabe abrufen.

Numph als NP importieren vom PIL -Importbild # Laden Sie das TFLite -Modell undzuordnen Tensoren zu interpreter = tf.lite.interpreter (model_path = 'mobilenet_v2.tflite') Interpreter.Allcate_tensors () # Eingangs- und Ausgabe -Tensoren abrufen input_details = interpreter.get_input_details () output_details = interpreter.get_output_details ()

Vorverarbeitungseingabe, Ausgangsausgang und Dekodierungsausgabe

Wir laden das Bild (CAT.JPG), die Gr??e auf die erforderlichen (224, 224) Pixel und die Vorverarbeitung mit der Vorverarbeitungsmethode von Mobilenetv2. Das vorverarbeitete Bild wird in das TFLite -Modell eingespeist, indem der Eingangstensor unter Verwendung vonInterPreter.set_tensor () festgelegt wird, und wir führen Inferenz mit interpreter.invoke () aus. Nach der Inferenz rufen wir die Vorhersagen des Modells ab und dekodieren sie mithilfe von deCode_Predictions () zu Namen und Wahrscheinlichkeiten von Menschenlesbar. Schlie?lich drucken wir die Vorhersagen.

# Laden und Vorverarbeitung des Eingangsbildes

Image = Image.open ('cat.jpg'). Gr??en?nderung ((224, 224)) # Ersetzen Sie Ihren Bildpfad durch

input_data = np.expand_dims (np.Array (Bild), Axis = 0)

input_data = tf.keras.applications.mobilenet_v2.preprocess_input (input_data)

# Legen Sie den Eingangstennsor ein und führen Sie das Modell aus

Interpreter.set_tensor (input_details [0] ['Index'], input_data)

interpreter.invoke ()

# Erhalten Sie den Ausgang und dekodieren Sie Vorhersagen

output_data = interpreter.get_tensor (output_details [0] ['index'])

Vorhersagen = tf.keras.applications.mobilenet_v2.decode_prredictions (output_data)

Druck (Vorhersagen)

Verwenden Sie das CAT -Bild unten:

Ausgabe:

[('N02123045', Tabby ', 0,85), (' N02124075 ',' ?gyptisch_cat ', 0,07), (' N02123159 ',' Tiger_cat ', 0,05)]

Dies bedeutet, dass das Modell zu 85% zuversichtlich ist, dass das Bild eine Tabby -Katze ist.

Pytorch Mobile Implementierung

Jetzt werden wir Pytorch Mobile implementieren. Wir werden ein einfaches vorgebildetes Modell wie ResNet18 verwenden, es in Torchscript umwandeln und Inferenz ausführen

Einrichten der Umgebung und Laden des ResNet18 -Modells

# Schritt 1: Richten Sie die Umgebung ein Taschenlampe importieren importieren # Laden Sie ein vorgezogenes ResNet18 -Modell Modell = models.resnet18 (vorbereitet = true) # Setzen Sie das Modell in den Bewertungsmodus model.eval ()

Umwandlung des Modells in Torchscript

Hier definieren wir ein Beispiel_input, der ein zuf?lliger Tensor der Gr??e ist [1, 3, 224, 224]. Dies simuliert eine Stapel von 1 Bild mit 3 Farbkan?len (RGB) und 224 × 224 Pixel. Es wird verwendet, um die Vorg?nge des Modells zu verfolgen. tramp.jit.trace () ist eine Methode, die das Pytorch -Modell in ein Torchscript -Modul umwandelt. Mit TorchScript k?nnen Sie das Modell au?erhalb von Python serialisieren und ausführen, z. B. in C oder mobilen Ger?ten. Das konvertierte Torchscript -Modell wird als "resnet18_Scripted.pt" gespeichert, sodass es sp?ter geladen und verwendet werden kann.

# Schritt 2: Konvertieren Sie in Torchscript

Beispiel_input = Torch.randn (1, 3, 224, 224) # Beispieleingabe für die Verfolgung

Traced_script_module = fackel.jit.trace (Modell, Beispiel_input)

# Speichern Sie das Torchscript -Modell

Traced_script_module.save ("resnet18_Scriptted.pt")

Laden Sie das Skriptmodell und machen Sie Vorhersagen

Wir verwenden t Torch.jit.load (), um das zuvor gespeicherte Torchscript -Modell aus der Datei "ResNet18_Scriptted.pt" zu laden. Wir erstellen eine neue zuf?llige Tensor input_data und simulieren erneut eine Bildeingabe mit Gr??e [1, 3, 224, 224]. Das Modell wird dann auf dieser Eingabe mit Loaded_Model (input_data) ausgeführt. Dies gibt die Ausgabe zurück, die die Rohwerte (Protokolls) für jede Klasse enth?lt. Um die vorhergesagte Klasse zu erhalten, verwenden wir Torch.max (Ausgabe, 1), der den Index der Klasse mit der h?chsten Punktzahl ergibt. Wir drucken die vorhergesagte Klasse mit vorhergesagtem ().

# Schritt 3: Laden und führen Sie das Skriptmodell aus und führen Sie sie aus

ladeed_model = t Torch.jit.load ("resnet18_Scriptted.pt"))

# Eingabedaten simulieren (ein zuf?lliger Bild -Tensor)

input_data = fackel.randn (1, 3, 224, 224)

# Führen Sie das Modell aus und erhalten Sie Vorhersagen

output = laded_model (input_data)

_, vorhergesagt = fackel.max (Ausgabe, 1)

print (f'Predicted Class: {vorhergesagt.Item ()} ')

Ausgabe:

Vorhergesagte Klasse: 107

Somit sagt das Modell voraus, dass die Eingabedaten zum Class Index 107 geh?rt.

Abschluss

TensorFlow Lite konzentriert sich mehr auf mobile Ger?te, w?hrend Pytorch Mobile eine allgemeinere CPU/GPU-gestrichene L?sung bietet. Im Vergleich zu Tensorflow Lite bietet Pytorch Mobile eine gr??ere Portabilit?t und ist auch leichter als Tensorflow lite und eng ingleiert in Google. In Kombination k?nnen sie Entwicklern in Echtzeit künstliche Intelligenzanwendungen mit hohen Funktionen auf den Handheld-Ger?ten der Entwickler implementieren. Diese Frameworks bef?higen die Benutzer mit der F?higkeit, ausgefeilte Modelle auf lokalen Maschinen auszuführen, und schreiben auf diese Weise die Regeln für die Art und Weise, wie mobile Anwendungen mit der Welt in Kontakt treten, über Fingerspitzen um.

Key Takeaways

- TensorFlow Lite und Pytorch Mobile bef?higen Entwickler, KI -Modelle für Edge -Ger?te effizient bereitzustellen.

- Beide Frameworks unterstützen plattformübergreifende Kompatibilit?t und verbessern die Reichweite mobiler AI-Anwendungen.

- TensorFlow Lite ist für die Leistungsoptimierung bekannt, w?hrend Pytorch Mobile in Flexibilit?t auszeichnet.

- Einfache Integrations- und Entwickler-freundliche Tools machen beide Frameworks für eine Vielzahl von AI-Anwendungsf?llen geeignet.

- Anwendungen in der realen Welt umfassen Branchen wie Gesundheitswesen, Einzelhandel und Unterhaltung und pr?sentieren ihre Vielseitigkeit.

H?ufig gestellte Fragen

Q1. Was ist der Unterschied zwischen Tensorflow Lite und Pytorch Mobile?A. TensorFlow Lite wird verwendet, wo wir eine hohe Leistung auf mobilen Ger?ten ben?tigen, w?hrend Pytorch Mobile verwendet wird, wo wir Flexibilit?t und einfache Integration in das vorhandene ?kosystem von Pytorch ben?tigen.

Q2. K?nnen Tensorflow Lite und Pytorch Mobile sowohl an Android als auch an iOS arbeiten?A. Ja, sowohl Tensorflow Lite als auch Pytorch Mobile arbeiten an Android und iOS.

Q3. Schreiben Sie eine Verwendung von Pytorch Mobile.A. Pytorch Mobile ist nützlich für Anwendungen, die Aufgaben wie Bild-, Gesichts- und Videoklassifizierung, Echtzeit-Objekterkennung, Reversion von Sprache zu Text usw. ausführen.

Q4. Schreiben Sie eine Verwendung von TensorFlow Lite Mobile.A. TensorFlow Lite Mobile ist nützlich für Anwendungen wie Robotik, IoT -Ger?te, Augmented Reality (AR), Virtual Reality (VR), natürliche Sprachverarbeitung (NLP) usw.

Die in diesem Artikel gezeigten Medien sind nicht im Besitz von Analytics Vidhya und werden nach Ermessen des Autors verwendet.

Das obige ist der detaillierte Inhalt vonTensorflow Lite gegen Pytorch Mobile. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Hei?e KI -Werkzeuge

Undress AI Tool

Ausziehbilder kostenlos

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem v?llig kostenlosen KI-Gesichtstausch-Tool aus!

Hei?er Artikel

Hei?e Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Hei?e Themen

KI -Investor stillte zum Stillstand? 3 Strategische Wege zum Kauf, Bau oder Partner mit KI -Anbietern

Jul 02, 2025 am 11:13 AM

KI -Investor stillte zum Stillstand? 3 Strategische Wege zum Kauf, Bau oder Partner mit KI -Anbietern

Jul 02, 2025 am 11:13 AM

Das Investieren boomt, aber Kapital allein reicht nicht aus. Mit zunehmender Bewertungen und Verblassen der Unterscheidungskraft müssen Investoren in AI-fokussierten Risikokonstrumentfonds eine wichtige Entscheidung treffen: Kaufen, Bau oder Partner, um einen Vorteil zu erlangen? Hier erfahren Sie, wie Sie jede Option bewerten - und PR

Agi und KI -Superintelligenz werden die Annahmesperre der menschlichen Decke stark treffen

Jul 04, 2025 am 11:10 AM

Agi und KI -Superintelligenz werden die Annahmesperre der menschlichen Decke stark treffen

Jul 04, 2025 am 11:10 AM

Reden wir darüber. Diese Analyse eines innovativen KI -Durchbruchs ist Teil meiner laufenden Forbes -S?ulenberichterstattung über die neueste in der KI, einschlie?lich der Identifizierung und Erkl?rung verschiedener wirksamer KI -Komplexit?ten (siehe Link hier). Auf dem Weg zu Agi und

Erstellen Sie Ihre erste LLM -Anwendung: Ein Anf?nger -Tutorial

Jun 24, 2025 am 10:13 AM

Erstellen Sie Ihre erste LLM -Anwendung: Ein Anf?nger -Tutorial

Jun 24, 2025 am 10:13 AM

Haben Sie jemals versucht, Ihr eigenes gro?es Sprachmodell (LLM) zu erstellen? Haben Sie sich jemals gefragt, wie Menschen ihre eigene LLM -Anwendung stellen, um ihre Produktivit?t zu steigern? LLM -Anwendungen haben sich in jedem Aspekt als nützlich erwiesen

Kimi K2: Das m?chtigste Open-Source-Agentenmodell

Jul 12, 2025 am 09:16 AM

Kimi K2: Das m?chtigste Open-Source-Agentenmodell

Jul 12, 2025 am 09:16 AM

Erinnern Sie sich an die Flut chinesischer Open-Source-Modelle, die die Genai-Industrie Anfang dieses Jahres gest?rt haben? W?hrend Deepseek die meisten Schlagzeilen machte, war Kimi K1.5 einer der herausragenden Namen in der Liste. Und das Modell war ziemlich cool.

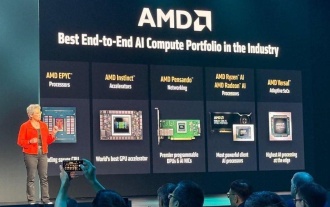

AMD baut immer wieder an Dynamik in KI auf

Jun 28, 2025 am 11:15 AM

AMD baut immer wieder an Dynamik in KI auf

Jun 28, 2025 am 11:15 AM

Insgesamt denke ich, dass die Veranstaltung wichtig war, um zu zeigen, wie AMD den Ball für Kunden und Entwickler auf dem Feld bewegt. Unter SU, M.O. ist klare, ehrgeizige Pl?ne zu haben und gegen sie auszuführen. Ihr Verh?ltnis von ?Say/Do“ ist hoch. Das Unternehmen tut es

Zukünftige Vorhersage einer massiven Intelligenz -Explosion auf dem Weg von AI zu AGI

Jul 02, 2025 am 11:19 AM

Zukünftige Vorhersage einer massiven Intelligenz -Explosion auf dem Weg von AI zu AGI

Jul 02, 2025 am 11:19 AM

Reden wir darüber. Diese Analyse eines innovativen KI -Durchbruchs ist Teil meiner laufenden Forbes -S?ulenberichterstattung über die neueste in der KI, einschlie?lich der Identifizierung und Erkl?rung verschiedener wirksamer KI -Komplexit?ten (siehe Link hier). Für diejenigen Leser, die h

Grok 4 gegen Claude 4: Was ist besser?

Jul 12, 2025 am 09:37 AM

Grok 4 gegen Claude 4: Was ist besser?

Jul 12, 2025 am 09:37 AM

Bis Mitte 2025 heizt sich das KI ?Wettret“ auf, und Xai und Anthropic haben beide ihre Flaggschiff-Modelle GROK 4 und Claude 4 ver?ffentlicht. Diese beiden Modelle befinden

Kette von Gedanken zum Argumentieren von Modellen kann langfristig nicht funktionieren

Jul 02, 2025 am 11:18 AM

Kette von Gedanken zum Argumentieren von Modellen kann langfristig nicht funktionieren

Jul 02, 2025 am 11:18 AM

Wenn Sie beispielsweise einem Modell eine Frage wie: "Was macht (x) Person bei (x) Firma?" M?glicherweise sehen Sie eine Argumentationskette, die ungef?hr so ??aussieht, vorausgesetzt, das System wei?, wie man die erforderlichen Informationen abgerufen: Details zum CO finden