Insgesamt10000 bezogener Inhalt gefunden

So installieren Sie Kafka von Docker

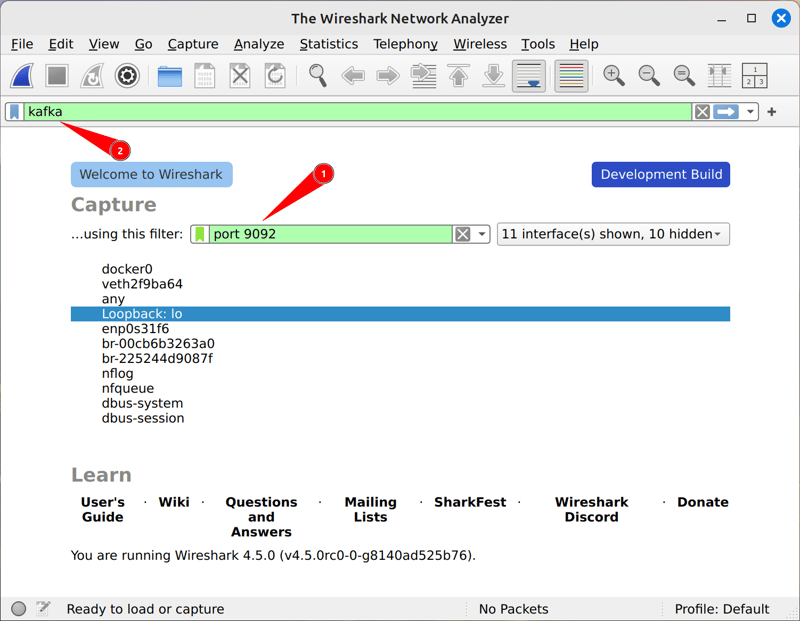

Artikeleinführung:Installieren Sie Kafka mit Docker -Schritten: Stellen Sie sicher, dass Docker in Ihrem System installiert ist. Ziehen Sie das offizielle Kafka -Bild von Docker Hub: Docker Pull Confluentinc/CP -Kafka Create und Start Kafka Container: Docker Run -d --Name Kafka -P 9092: 9092 Confluentinc/CP -Kafka verwenden Docker -Logs Kafka, um die Container -Logs zu überprüfen, um zu überprüfen, ob Kafka l?uft. Greifen Sie über Ihren Browser auf das KAFKA -Bedienfeld zu: http: // localh

2025-04-15

Kommentar 0

1172

Schaffung von Kafka -Verbrauchern mit Reaktor Kafka

Artikeleinführung:In diesem Artikel wird beschrieben, dass skalierbare und belastbare Kafka -Verbraucher mit Reaktor Kafka im Spring Boot erstellt werden. Es deckt Konfiguration, Nachrichtenverarbeitung, Backdruckverwaltung (mit Buffer, OnbackPressuredrop usw.), robuster Fehlerbehandlung (Wiederholungen, D.

2025-03-07

Kommentar 0

687

Kafka Keys verstehen: Ein umfassender Leitfaden

Artikeleinführung:Apache Kafka ist eine leistungsstarke Plattform für verteilte Ereignisstreams, die h?ufig zum Erstellen realer Zeitpipelines und -anwendungen verwendet wird. Eine seiner Kernfunktionen ist der Kafka -Nachrichtenschlüssel, der eine wichtige Rolle bei Nachrichtenpartitionen, Sortieren und Routing spielt. In diesem Artikel wird das Konzept, die Wichtigkeit und die tats?chlichen Beispiele des Kafka -Schlüssels untersucht.

Was ist der Kafka -Schlüssel?

In Kafka enth?lt jede Nachricht zwei Hauptkomponenten:

Schlüssel: Bestimmen Sie die Partition, dass die Nachricht gesendet wird.

Wert: Die tats?chlichen Daten der Nachricht sind effektiv.

Kafka -Produzenten verwenden Schlüssel, um den Hash -Wert zu berechnen, der die spezifische Partition der Nachricht bestimmt. Wenn der Schlüssel nicht bereitgestellt wird, wird die Nachricht in jedem von jedem verteilt

2025-01-29

Kommentar 0

1147

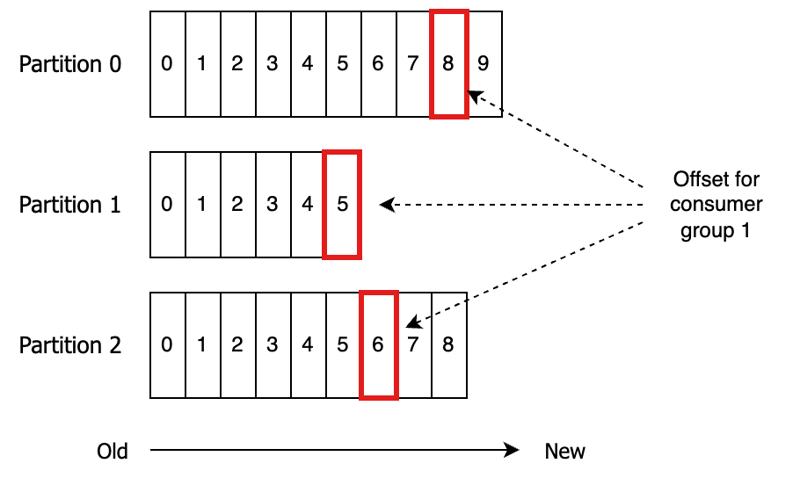

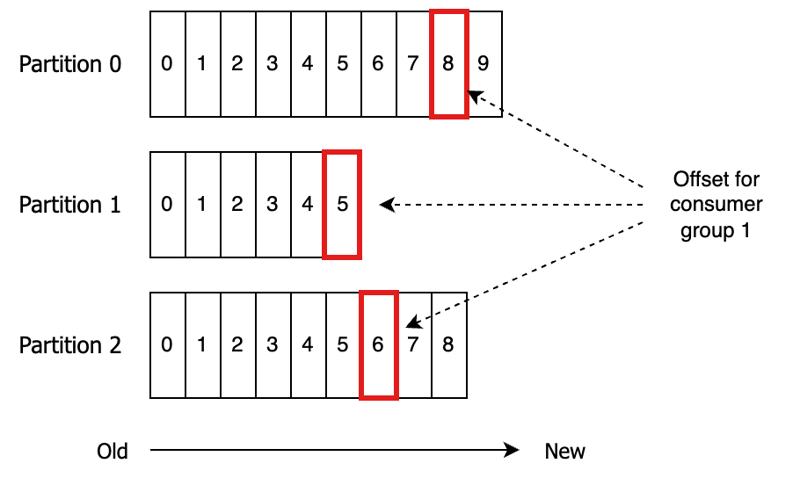

Kafka Consumer - Verschiebung der Verbrauchergruppe begehen

Artikeleinführung:Kafka Consumer Group Offsets verstehen: Ein umfassender Leitfaden

In diesem Leitfaden werden Kafka-Verbrauchergruppen-Offsets untersucht, die für die Verfolgung des Nachrichtenverbrauchsfortschritts von entscheidender Bedeutung sind. Jede Verbrauchergruppe verwaltet einen Offset für jede von ihr genutzte Partition, was darauf hinweist

2025-01-26

Kommentar 0

1116

Arbeiten mit reaktivem Kafka -Stream und Spring WebFlux

Artikeleinführung:In diesem Artikel werden reaktionsschnelle, skalierbare ereignisgesteuerte Apps mit reaktiven Kafka-Streams und Spring WebFlux erstellt. Es betont die effiziente Backpressure -Handhabung über Kafka -Verbrauchereinstellungen und Projektreaktorbetreiber und befürwortet das Verst?ndnis

2025-03-07

Kommentar 0

952

KAFKA -Nachrichtenbest?tigungsoptionen

Artikeleinführung:In diesem Artikel werden die Optionen zur Best?tigung der KAFKA untersucht: automatisch, manuell synchron, manuell asynchron und manuell mit bestimmten Offsets. Es analysiert ihre Leistungsverk?ufe zwischen Durchsatz und Zuverl?ssigkeit und führt die Leser in SELE an

2025-03-07

Kommentar 0

697

Aufbau eines Kafka-Produzenten und -Konsumenten in Go

Artikeleinführung:Apache Kafka ist eine leistungsstarke verteilte Streaming-Plattform, die zum Aufbau von Echtzeit-Datenpipelines und Streaming-Anwendungen verwendet wird. In diesem Blogbeitrag gehen wir Schritt für Schritt durch die Einrichtung eines Kafka-Produzenten und -Konsumenten mit Golang.

Voraussetzungen

Sei

2025-01-03

Kommentar 0

999

Beschleunigen Sie GenAI: Streamen Sie Daten von MySQL nach Kafka

Artikeleinführung:Im Zeitalter der KI wird Apache Kafka aufgrund seiner hohen Leistung beim Echtzeit-Datenstreaming und -verarbeitung zu einer zentralen Kraft. Viele Unternehmen m?chten Daten in Kafka integrieren, um die Effizienz und Gesch?ftsflexibilit?t zu steigern. In diesem Fall

2024-11-03

Kommentar 0

340

RabbitMQ vs. Kafka: Auswahl des richtigen Nachrichtenbrokers für Ihre Java-Anwendung

Artikeleinführung:Vergleich von RabbitMQ und Kafka:

Wenn Sie sich für Ihre Message-Brokering-Anforderungen zwischen RabbitMQ und Kafka entscheiden, ist es wichtig, deren einzigartige St?rken und besten Anwendungsf?lle zu verstehen.

RabbitMQ ist ein traditioneller Nachrichtenbroker, der ein Push-Modell für Deli verwendet

2024-11-12

Kommentar 0

648

Wie verbinde ich Kafka mit einer Go -Anwendung?

Artikeleinführung:Zu den wichtigsten Schritten für die Verbindung mit GO und die Verwendung von KAFKA geh?rt die Installation der KAFKA-GO-Bibliothek, das Schreiben von Produzenten zum Senden von Nachrichten, das Schreiben von Verbrauchern, um Nachrichten zu erhalten, und das Beachten auf gemeinsame Probleme. 1. Installieren Sie die KAFKA-GO-Bibliothek, um Abh?ngigkeiten über GOMOD zu verwalten. 2. Erstellen Sie den Produzenten, um Nachrichten mit dem angegebenen Thema mit dem Schriftsteller zu senden. 3. Erstellen Sie den Verbraucher, um den Leser zu verwenden, um Nachrichten aus dem angegebenen Thema zu ziehen. 4. Achten Sie auf Details wie Broker -Adresse, Themenname, Einstellungen für Verbrauchergruppen und Leistungsstimmen.

2025-07-17

Kommentar 0

115

Belay the Metamorphosis: Analyse des Kafka-Projekts

Artikeleinführung:Haben Sie sich jemals gefragt, welche Fehler im Projektquellcode globaler Unternehmen lauern k?nnten? Verpassen Sie nicht die Gelegenheit, interessante Fehler zu entdecken, die vom statischen Analysator PVS-Studio im Open-Source-Projekt Apache Kafka entdeckt wurden.

Vorstellen

2024-10-16

Kommentar 0

745

Kafka-Grundlagen mit einem praktischen Beispiel

Artikeleinführung:In den letzten Wochen habe ich mich intensiv mit Kafka besch?ftigt und mir dabei Notizen gemacht. Ich habe beschlossen, daraus einen Blog-Beitrag zu organisieren und zu strukturieren. Neben Konzepten und Tipps gibt es auch ein praktisches Beispiel, das mit NestJS und KafkaJs erstellt wurde .

2024-12-28

Kommentar 0

557

Datenpipelines mit Apache Kafka im Jahr 2025 revolutionieren

Artikeleinführung:In diesem Artikel werden die Rolle von Apache Kafka in der Datenpipeline-Architektur bis 2025 untersucht. Er geht von Herausforderungen wie explodiertem Datenvolumen, Echtzeitanalyseanforderungen und komplexen Datenquellen vor. Der Artikel zeigt Kafkas Skalierbarkeit, Echtzeit Capab

2025-03-07

Kommentar 0

504

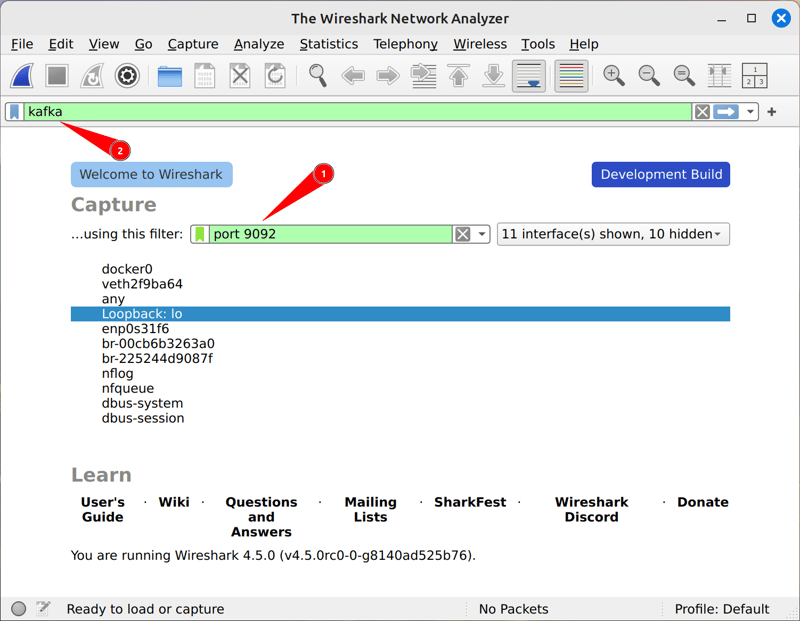

Praktischer Leitfaden zum Kafka-Protokoll

Artikeleinführung:Ich habe ziemlich viel mit dem Apache Kafka-Protokoll auf der unteren Ebene gearbeitet. Es war nicht einfach, damit anzufangen, indem ich nur der offiziellen Anleitung folgte, und ich habe den Code oft gelesen. Mit diesem Beitrag m?chte ich Ihnen einen Vorsprung verschaffen, indem ich Sie von Anfang an Schritt für Schritt anleite

2024-12-28

Kommentar 0

586