Pernahkah anda cuba membina aplikasi Model Besar (LLM) anda sendiri? Pernah tertanya -tanya bagaimana orang membuat aplikasi LLM mereka sendiri untuk meningkatkan produktiviti mereka? Aplikasi LLM telah terbukti berguna dalam setiap aspek. Membina aplikasi LLM kini berada dalam jangkauan semua orang. Terima kasih kepada ketersediaan model AI serta rangka kerja yang kuat. Dalam tutorial ini, kami akan membina aplikasi LLM pertama kami dengan cara yang paling mudah. Mari mulakan prosesnya. Kami akan menyelidiki setiap proses dari idea ke kod ke penggunaan satu demi satu.

Jadual Kandungan

- Mengapa aplikasi LLM penting?

- Komponen utama aplikasi LLM

- Memilih alat yang betul

- Pelaksanaan langkah demi langkah

- 1. Menyediakan Python dan persekitarannya

- 2. Memasang kebergantungan yang diperlukan

- 3. Mengimport semua kebergantungan

- 4. Persediaan Persekitaran

- 5. Persediaan Ejen

- 6. Streamlit UI

- 7. Menjalankan permohonan

- Kesimpulan

- Soalan yang sering ditanya

Mengapa aplikasi LLM penting?

Aplikasi LLM adalah unik kerana mereka menggunakan bahasa semulajadi untuk memproses pengguna dan juga bertindak balas dalam bahasa semula jadi. Selain itu, aplikasi LLM menyedari konteks pertanyaan pengguna dan menjawabnya dengan sewajarnya. Kes penggunaan biasa aplikasi LLM adalah chatbots, penjanaan kandungan, dan ejen Q & A. Ia memberi kesan kepada pengalaman pengguna dengan ketara dengan menggabungkan AI perbualan, pemandu landskap AI hari ini.

Komponen utama aplikasi LLM

Mewujudkan aplikasi LLM melibatkan langkah -langkah di mana kami membuat komponen yang berbeza dari aplikasi LLM. Pada akhirnya, kami menggunakan komponen ini untuk membina aplikasi sepenuhnya. Mari kita pelajari mereka satu demi satu untuk mendapatkan pemahaman yang lengkap tentang setiap komponen dengan teliti.

- Model asas: Ini melibatkan memilih model AI asas atau LLM yang akan anda gunakan dalam aplikasi anda di backend. Pertimbangkan ini sebagai otak permohonan anda.

- Kejuruteraan Prompt: Ini adalah komponen yang paling penting untuk memberikan konteks LLM anda mengenai aplikasi anda. Ini termasuk menentukan nada, keperibadian, dan persona LLM anda supaya ia dapat menjawab dengan sewajarnya.

- Lapisan Orchestration: Rangka kerja seperti Langchain, Llamaindex bertindak sebagai lapisan orkestra, yang mengendalikan semua panggilan dan output LLM anda ke aplikasi anda. Rangka kerja ini mengikat aplikasi anda dengan LLM supaya anda dapat mengakses model AI dengan mudah.

- Alat: Alat bertindak sebagai komponen yang paling penting semasa membina aplikasi LLM anda. Alat ini sering digunakan oleh LLM untuk melaksanakan tugas -tugas yang model AI tidak mampu melakukan secara langsung.

Memilih alat yang betul

Memilih alat yang betul adalah salah satu tugas yang paling penting untuk membuat aplikasi LLM. Orang sering melangkau bahagian proses ini dan mula membina aplikasi LLM dari awal dengan menggunakan alat yang tersedia. Pendekatan ini sangat samar -samar. Orang harus menentukan alat dengan cekap sebelum masuk ke fasa pembangunan. Mari 'Tentukan alat kami.

- Memilih LLM: LLM bertindak sebagai minda di belakang permohonan anda. Memilih LLM yang betul adalah langkah penting, mengekalkan kos dan ketersediaan parameter dalam fikiran. Anda boleh menggunakan LLMS dari OpenAI, Groq, dan Google. Anda perlu mengumpul kunci API dari platform mereka untuk menggunakan LLM ini.

- Rangka Kerja: Rangka kerja bertindak sebagai integrasi antara aplikasi anda dan LLM. Ia membantu kami dalam memudahkan arahan ke LLM, logik chaining yang mentakrifkan aliran kerja aplikasi. Terdapat rangka kerja seperti Langchain dan Llamaindex yang digunakan secara meluas untuk membuat aplikasi LLM. Langchain dianggap paling mesra pemula dan paling mudah digunakan.

- Perpustakaan Front-End: Python menawarkan sokongan yang baik untuk membina front-end untuk aplikasi anda dalam kod minimum yang mungkin. Perpustakaan seperti Streamlit, Gradio, dan Chainlit mempunyai keupayaan untuk memberikan aplikasi LLM anda hujung depan yang indah dengan kod minimum yang diperlukan.

Pelaksanaan langkah demi langkah

Kami telah meliputi semua prasyarat asas untuk membina aplikasi LLM kami. Mari kita bergerak ke arah pelaksanaan sebenar dan tulis kod untuk membangunkan aplikasi LLM dari awal. Dalam panduan ini, kami akan membuat aplikasi LLM yang mengambil pertanyaan sebagai input, memecahkan pertanyaan ke dalam sub-bahagian, mencari Internet, dan kemudian menyusun hasilnya ke dalam laporan markdown yang baik dengan rujukan yang digunakan.

1. Menyediakan Python dan persekitarannya

Langkah pertama ialah memuat turun penterjemah Python dari laman web rasminya dan memasangnya pada sistem anda. Jangan lupa untuk menandakan/pilih pembolehubah Tambah Laluan ke pilihan sistem semasa memasang.

Juga, sahkan bahawa anda telah memasang python dengan menaip python dalam baris arahan.

2. Memasang kebergantungan yang diperlukan

Langkah ini memasang kebergantungan perpustakaan ke dalam sistem anda. Buka terminal anda dan taipkan arahan berikut untuk memasang kebergantungan.

PIP Pasang Streamlit Dotenv Langchain Langchain-Openai Langchain-Community Langchain-Core

Perintah ini akan menjalankan terminal dan memasang semua kebergantungan untuk menjalankan aplikasi kami.

3. Mengimport semua kebergantungan

Selepas memasang kebergantungan, pergi ke editor kod IDE, seperti kod VS, dan membukanya di laluan yang diperlukan. Sekarang, buat fail python "app.py" dan tampal pernyataan import berikut di dalam fail

Import Streamlit sebagai ST Import OS dari dotenv import load_dotenv dari langchain_openai import chatopenai dari langchain_community.tools.Tavily_Search Import TavilySearchResults dari Langchain.Agents Import AgentExecutor, create_tool_calling_agent dari langchain_core.Prompts import chatprompttemplate, mesej tempat dari langchain_core.Messages Import Aimessage, HumanMessage

4. Persediaan Persekitaran

Kami membuat beberapa pembolehubah persekitaran untuk LLM kami dan alat lain. Untuk ini, buat fail ".env" dalam direktori yang sama dan tampal kekunci API di dalamnya menggunakan pembolehubah persekitaran. Sebagai contoh, dalam aplikasi LLM kami, kami akan menggunakan dua kekunci API: kunci API OpenAI untuk LLM kami, yang boleh diakses dari sini, dan kunci API Tavily, yang akan digunakan untuk mencari Internet dalam masa nyata, yang boleh diakses dari sini.

Openai_api_key = "your_api_key" Tavily_api_key = "your_api_key"

Sekarang, dalam app.py anda, tulis sekeping kod berikut. Kod ini akan memuat semua pembolehubah persekitaran yang tersedia terus ke dalam persekitaran kerja anda.

# --- Persediaan Persekitaran ---

LOAD_DOTENV ()

Openai_api_key = os.getenv ("openai_api_key")

Tavily_api_key = os.getenv ("tavily_api_key")

Sekiranya tidak OpenAI_API_KEY:

St.error ("? Kunci API Openai tidak dijumpai. Sila tetapkannya dalam fail .env anda (OpenAI_API_KEY = 'SK -...')")

Sekiranya tidak tavily_api_key:

St.error ("Kunci API Tavily tidak dijumpai. Sila tetapkannya dalam fail .env anda (tavily_api_key = 'tvly -...')")

Sekiranya tidak OpenAI_API_KEY atau tidak tavily_api_key:

Ststop ()

5. Persediaan Ejen

Seperti yang kita telah memuatkan semua pembolehubah persekitaran. Mari buat aliran kerja agentik bahawa setiap pertanyaan akan bergerak melalui semasa menggunakan aplikasi LLM. Di sini kita akan mencipta alat iaitu, carian tavily, yang akan mencari internet. Seorang pelaksana ejen yang akan melaksanakan ejen dengan alat.

# --- persediaan ejen ---

@St.Cache_Resource

def get_agent_executor ():

"" "

Memulakan dan mengembalikan pelaksana ejen Langchain.

"" "

# 1. Tentukan LLM

LLM = chatopenai (model = "gpt-4o-mini", suhu = 0.2, api_key = openai_api_key)

# 2. Tentukan alat (pengisytiharan mudah)

alat = [

TavilysearchResults (

max_results = 7,

nama = "web_search",

api_key = tavily_api_key,

Penerangan = "Melakukan carian web untuk mencari maklumat semasa"

)

]

# 3. Templat Prompt yang Dikemaskini (V0.3 Amalan Terbaik)

prompt_template = chatprompttemplate.from_messages (

[

("Sistem", "" "

Anda adalah pembantu penyelidik bertaraf dunia AI. Memberi jawapan yang komprehensif dan tepat dengan petikan markdown.

Proses:

1. Decomplexify soalan ke dalam sub-kuar

2. Gunakan `web_search` untuk setiap sub-pertanyaan

3. Sintesis maklumat

4. Cite Sumber menggunakan nota kaki markdown

5. Sertakan senarai rujukan

Soalan susulan harus menggunakan konteks sejarah sembang.

"" "),

Mesej Pemasaran ("Chat_history", Pilihan = Benar),

("manusia", "{input}"),

Mesej Pencapaian ("Agent_ScratchPad"),

]

)

# 4. Buat Ejen (Dikemaskini ke Create_Tool_Calling_Agent)

agen = create_tool_calling_agent (llm, alat, prompt_template)

# 5. AgentExecutor dengan Konfigurasi Moden

Pulangan AgentExecutor (

ejen = ejen,

alat = alat,

verbose = benar,

handle_parsing_errors = benar,

max_iterations = 10,

return_intermediate_steps = true

)

Di sini kita menggunakan templat segera yang mengarahkan GPT-4O-Mini LLM, bagaimana untuk melakukan bahagian carian, menyusun laporan dengan rujukan. Bahagian ini bertanggungjawab untuk semua kerja backend aplikasi LLM anda. Sebarang perubahan dalam seksyen ini akan secara langsung mempengaruhi keputusan permohonan LLM anda.

6. Streamlit UI

Kami telah menubuhkan semua logik backend untuk aplikasi LLM kami. Sekarang, mari buat UI untuk permohonan kami, yang akan bertanggungjawab untuk pandangan frontend permohonan kami.

# --- streamlit ui ---

St.Set_page_config (page_title = "AI Research Agent?", Page_icon = "?", Layout = "Wide")

Stmarkdown ("" "

<style>

???.stChatMessage {

???????border-radius: 10px;

???????padding: 10px;

???????margin-bottom: 10px;

???}

???.stChatMessage.user {

???????background-color: #E6F3FF;

???}

???.stChatMessage.assistant {

???????background-color: #F0F0F0;

???}

???</style>

"" ", unsafe_allow_html = benar)

St.Title ("AI Ejen Penyelidikan AI")

St.Caption ("Pembantu AI Lanjutan anda untuk mencari web, mensintesis maklumat, dan memberikan jawapan yang disebut.")

jika "chat_history" tidak di s.session_state:

s.session_state.chat_history = []

untuk message_obj di s.session_state.chat_history:

Peranan = "Pengguna" jika isInstance (Message_obj, HumanMessage) lain "Pembantu"

dengan st.chat_message (peranan):

Stmarkdown (message_obj.content)

user_query = st.chat_input ("Tanya soalan penyelidikan ...")

Sekiranya user_query:

s.session_state.chat_history.append (HumanMessage (Content = user_Query))

dengan st.chat_message ("pengguna"):

Stmarkdown (user_query)

dengan st.chat_message ("pembantu"):

dengan St.Spinner ("? Berfikir & Menyelidik ..."):

Cuba:

agen_executor = get_agent_executor ()

respons = agen_executor.invoke ({

"input": user_query,

"Chat_history": St.Session_State.Chat_History [:-1]

})

Jawapan = Respons ["Output"]

s.session_state.chat_history.append (Aimessage (kandungan = jawapan))

Stmarkdown (jawapan)

Kecuali pengecualian sebagai e:

error_message = f "? Minta maaf, ralat berlaku: {str (e)}"

St.Ror (error_message)

cetak (f "ralat semasa penyerahan ejen: {e}")

Dalam bahagian ini, kami mendefinisikan tajuk, kapsyen, keterangan, dan sejarah sembang permohonan kami. StreamLit menawarkan banyak fungsi untuk menyesuaikan aplikasi kami. Kami telah menggunakan beberapa pilihan penyesuaian yang terhad di sini untuk menjadikan aplikasi kami kurang kompleks. Anda bebas menyesuaikan permohonan anda dengan keperluan anda.

7. Menjalankan permohonan

Kami telah menentukan semua bahagian untuk permohonan kami, dan kini sudah siap untuk dilancarkan. Mari kita lihat secara visual apa yang telah kita buat dan menganalisis hasilnya.

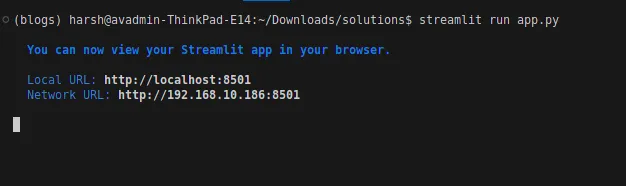

Buka terminal dan taip anda

Streamlit Run App.py

Ini akan memulakan permohonan anda, dan anda akan diarahkan ke pelayar lalai anda.

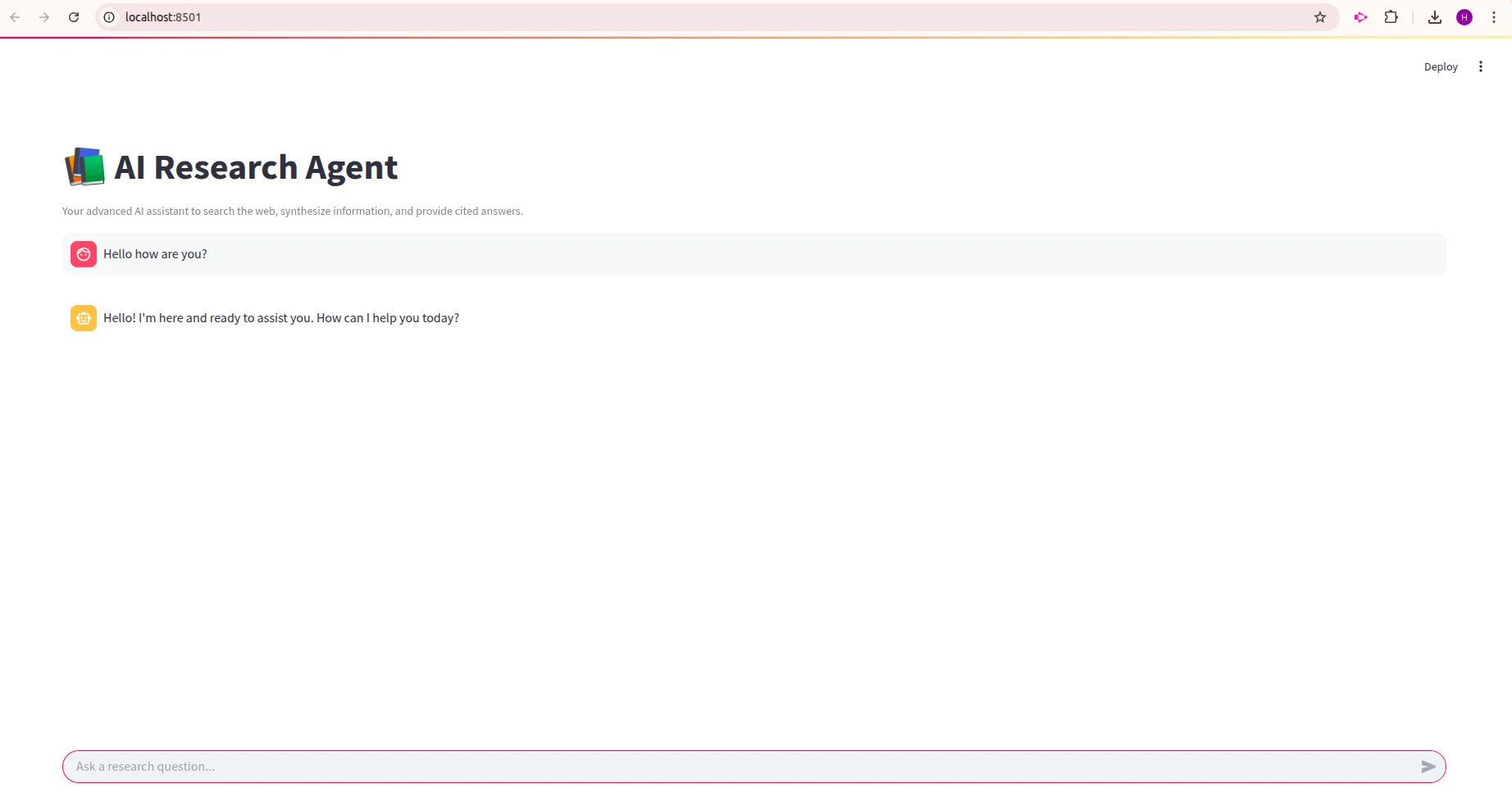

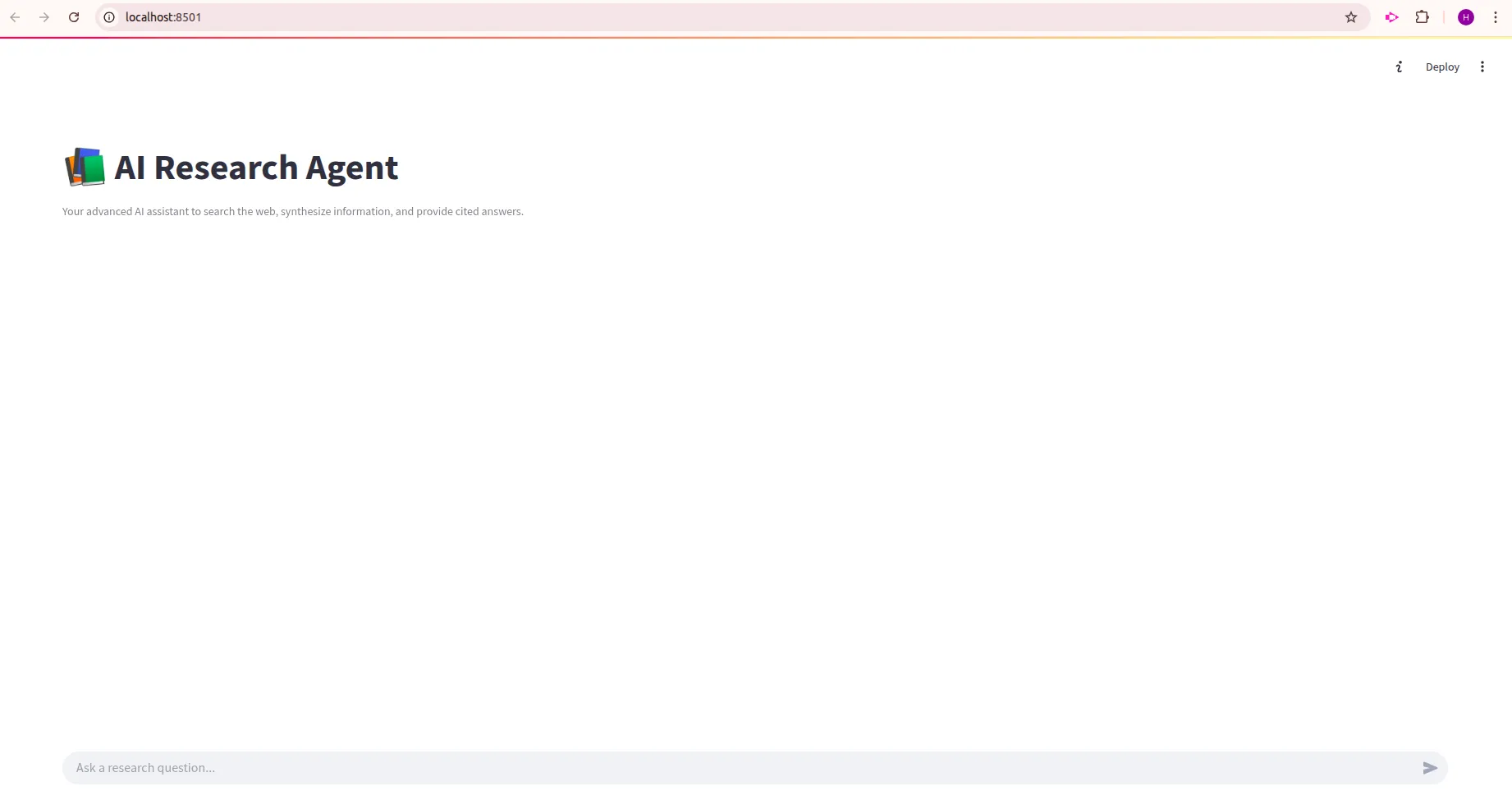

Ini adalah UI aplikasi LLM anda:

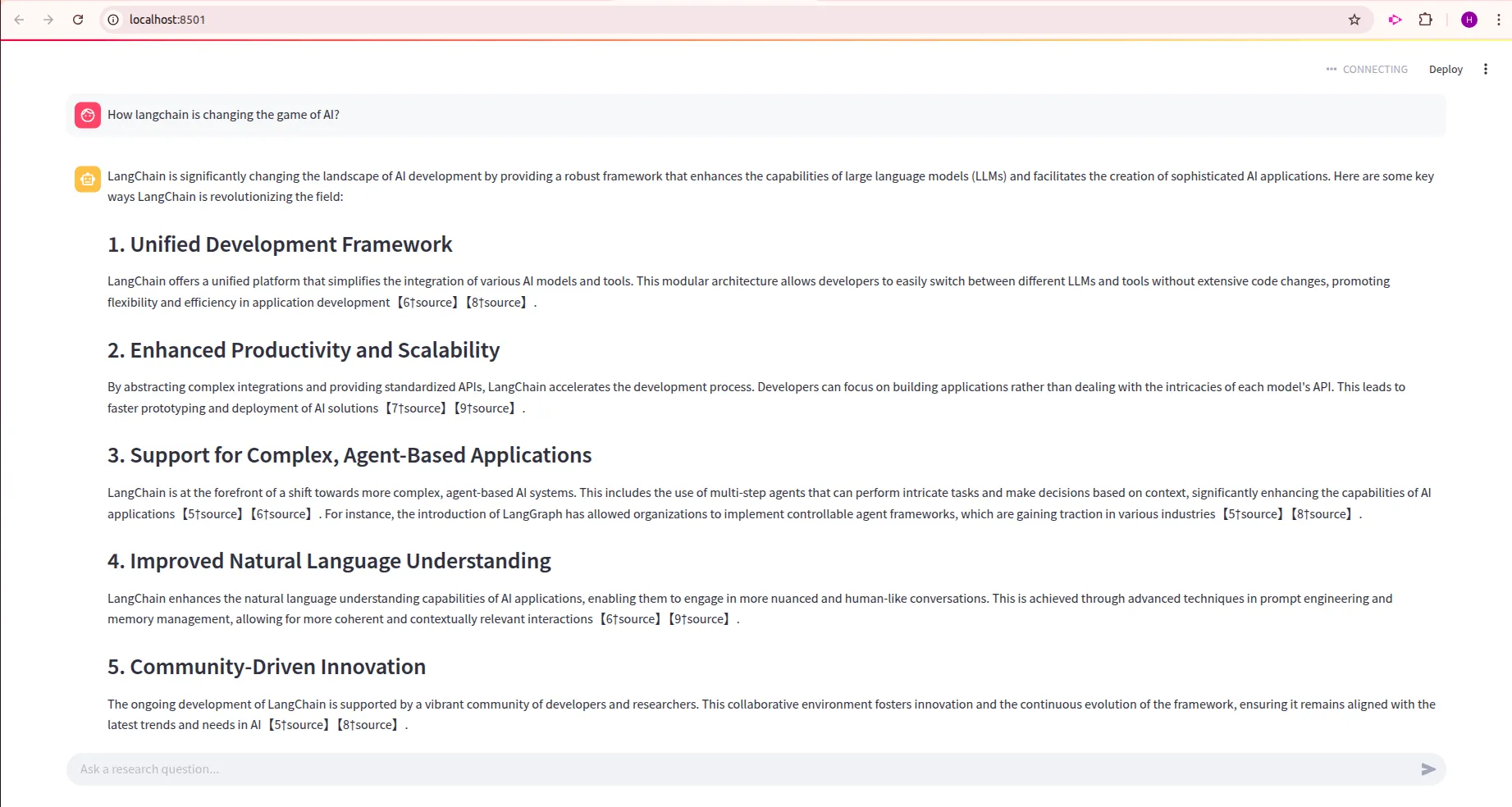

Mari cuba menguji aplikasi LLM kami

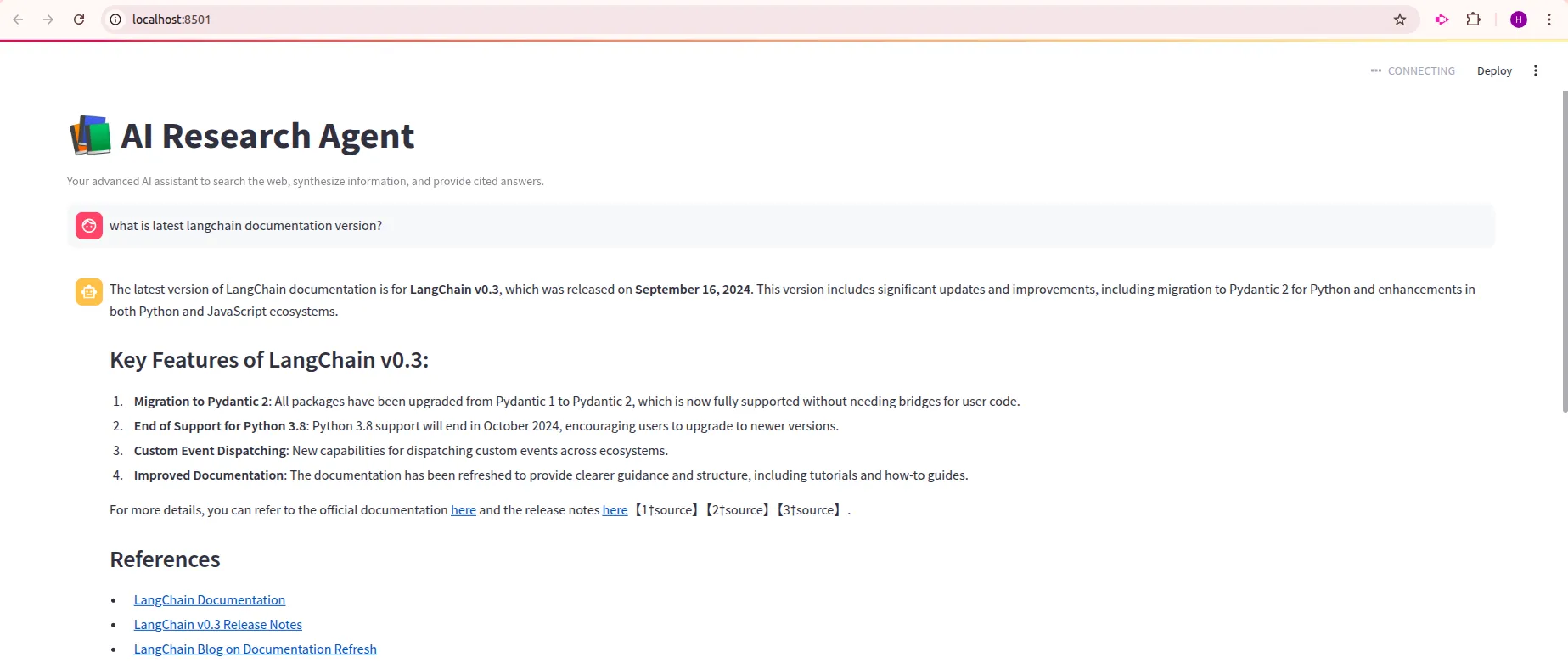

Pertanyaan : "Apakah versi dokumentasi Langchain terkini?"

Pertanyaan : "Bagaimana Langchain mengubah permainan AI?"

Dari output, kita dapat melihat bahawa aplikasi LLM kami menunjukkan hasil yang diharapkan. Hasil terperinci dengan pautan rujukan. Sesiapa sahaja boleh mengklik pada pautan rujukan ini untuk mengakses konteks dari mana LLM kami menjawab soalan. Oleh itu, kami telah berjaya mencipta aplikasi LLM pertama kami. Jangan ragu untuk membuat perubahan dalam kod ini dan membuat beberapa aplikasi yang lebih kompleks, mengambil kod ini sebagai rujukan.

Kesimpulan

Mewujudkan aplikasi LLM telah menjadi lebih mudah berbanding sebelum ini. Jika anda membaca ini, ini bermakna anda mempunyai pengetahuan yang cukup untuk membuat aplikasi LLM anda sendiri. Dalam panduan ini, kami pergi menubuhkan persekitaran, menulis Kod, Logik Agen, menentukan UI APP, dan juga menukarnya ke dalam aplikasi Streamlit. Ini merangkumi semua langkah utama dalam membangunkan aplikasi LLM. Cuba untuk bereksperimen dengan templat segera, rantai LLM, dan penyesuaian UI untuk menjadikan aplikasi anda diperibadikan mengikut keperluan anda. Ia hanya permulaan; Aliran kerja AI yang lebih kaya sedang menunggu anda, dengan ejen, ingatan, dan tugas khusus domain.

Soalan yang sering ditanya

Q1. Adakah saya perlu melatih model dari awal?A. Tidak, anda boleh bermula dengan LLM yang terlatih (seperti GPT atau Open-Source Ones), memberi tumpuan kepada reka bentuk cepat dan logik aplikasi.

S2. Mengapa menggunakan rangka kerja seperti Langchain?A. Mereka memudahkan chaining arahan, mengendalikan memori, dan mengintegrasikan alat, tanpa mencipta semula roda.

Q3. Bagaimana saya boleh menambah memori perbualan?A. Gunakan kelas memori penampan dalam rangka kerja (contohnya, Langchain) atau mengintegrasikan pangkalan data vektor untuk mendapatkan semula.

Q4. Apa itu kain dan mengapa menggunakannya?A. Generasi pengambilan semula membawa data luaran ke dalam konteks model, meningkatkan ketepatan tindak balas pada pertanyaan khusus domain.

S5. Di mana saya boleh menggunakan aplikasi LLM saya?A. Mulailah dengan demo tempatan menggunakan Vadio, kemudian skala menggunakan ruang muka yang memeluk, awan Streamlit, Heroku, Docker, atau platform awan.

Atas ialah kandungan terperinci Bina Aplikasi LLM Pertama Anda: Tutorial pemula ' s. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undress AI Tool

Gambar buka pakaian secara percuma

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Kimi K2: Model agentik sumber terbuka yang paling kuat

Jul 12, 2025 am 09:16 AM

Kimi K2: Model agentik sumber terbuka yang paling kuat

Jul 12, 2025 am 09:16 AM

Ingat banjir model Cina sumber terbuka yang mengganggu industri Genai awal tahun ini? Walaupun Deepseek mengambil sebahagian besar tajuk utama, Kimi K1.5 adalah salah satu nama yang terkenal dalam senarai. Dan model itu agak sejuk.

Grok 4 vs Claude 4: Mana yang lebih baik?

Jul 12, 2025 am 09:37 AM

Grok 4 vs Claude 4: Mana yang lebih baik?

Jul 12, 2025 am 09:37 AM

Menjelang pertengahan tahun 2025, AI "perlumbaan senjata" dipanaskan, dan Xai dan Anthropic kedua-duanya mengeluarkan model perdana mereka, Grok 4 dan Claude 4. Kedua-dua model ini berada di hujung falsafah reka bentuk dan platform penempatan, namun mereka

10 robot humanoid yang menakjubkan sudah berjalan di antara kita hari ini

Jul 16, 2025 am 11:12 AM

10 robot humanoid yang menakjubkan sudah berjalan di antara kita hari ini

Jul 16, 2025 am 11:12 AM

Tetapi kita mungkin tidak perlu menunggu 10 tahun untuk melihatnya. Malah, apa yang boleh dianggap sebagai gelombang pertama yang benar-benar berguna, mesin seperti manusia sudah ada di sini. Tahun -tahun kebelakangan ini telah melihat beberapa prototaip dan model pengeluaran melangkah keluar dari T

Aplikasi mudah alih Immersity Leia membawa kedalaman 3D ke foto sehari -hari

Jul 09, 2025 am 11:17 AM

Aplikasi mudah alih Immersity Leia membawa kedalaman 3D ke foto sehari -hari

Jul 09, 2025 am 11:17 AM

Dibina di atas enjin kedalaman saraf proprietari Leia, aplikasinya memproses imej dan menambah kedalaman semula jadi bersama -sama dengan gerakan simulasi -seperti kuali, zum, dan kesan paralaks -untuk membuat gulungan video pendek yang memberikan kesan melangkah ke SCE

Kejuruteraan Konteks adalah ' baru ' Kejuruteraan segera

Jul 12, 2025 am 09:33 AM

Kejuruteraan Konteks adalah ' baru ' Kejuruteraan segera

Jul 12, 2025 am 09:33 AM

Sehingga tahun sebelumnya, kejuruteraan segera dianggap sebagai kemahiran penting untuk berinteraksi dengan model bahasa yang besar (LLM). Walau bagaimanapun, baru -baru ini, LLM telah maju dengan ketara dalam kebolehan pemikiran dan pemahaman mereka. Sememangnya, jangkaan kami

Apakah 7 jenis ejen AI?

Jul 11, 2025 am 11:08 AM

Apakah 7 jenis ejen AI?

Jul 11, 2025 am 11:08 AM

Gambar sesuatu yang canggih, seperti enjin AI yang bersedia memberikan maklum balas terperinci mengenai koleksi pakaian baru dari Milan, atau analisis pasaran automatik untuk perniagaan yang beroperasi di seluruh dunia, atau sistem pintar yang menguruskan armada kenderaan yang besar.

Model AI ini tidak belajar bahasa, mereka belajar strategi

Jul 09, 2025 am 11:16 AM

Model AI ini tidak belajar bahasa, mereka belajar strategi

Jul 09, 2025 am 11:16 AM

Satu kajian baru dari penyelidik di King's College London dan University of Oxford berkongsi hasil apa yang berlaku ketika Openai, Google dan Anthropic dibuang bersama dalam pertandingan cutthroat berdasarkan dilema banduan berulang. Ini tidak

Krisis Komando yang tersembunyi: Penyelidik Permainan AI untuk Diterbitkan

Jul 13, 2025 am 11:08 AM

Krisis Komando yang tersembunyi: Penyelidik Permainan AI untuk Diterbitkan

Jul 13, 2025 am 11:08 AM

Para saintis telah menemui kaedah yang bijak namun membimbangkan untuk memintas sistem. Julai 2025 menandakan penemuan strategi yang rumit di mana penyelidik memasukkan arahan yang tidak kelihatan ke dalam penyerahan akademik mereka - arahan rahsia ini adalah ekor