10000 contenu connexe trouvé

Comment installer Kafka par Docker

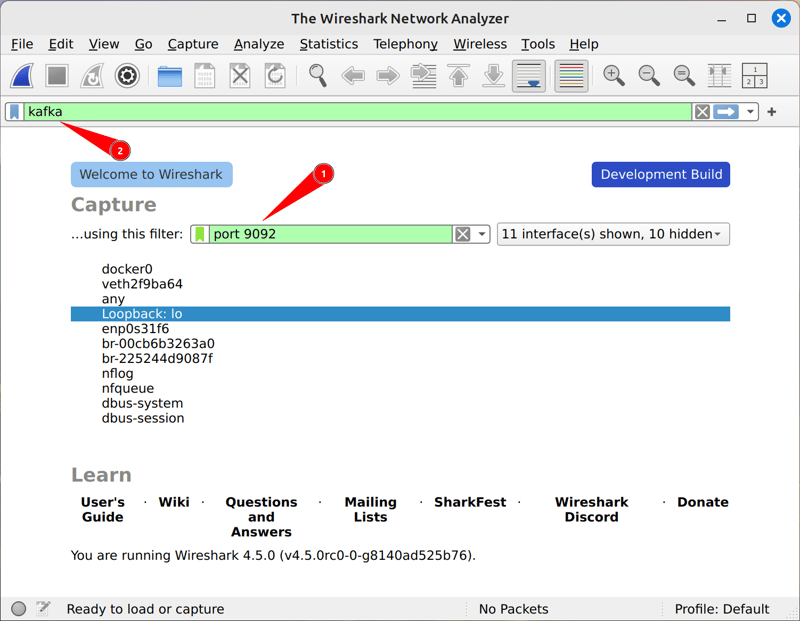

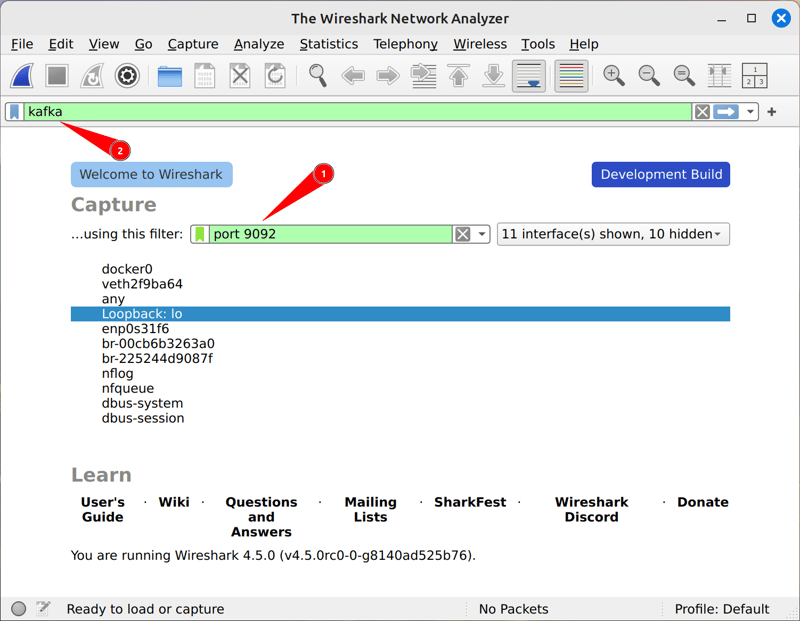

Présentation de l'article:Installez Kafka à l'aide des étapes Docker: assurez-vous que Docker est installé sur votre système. Tirez l'image officielle de Kafka de Docker Hub: Docker Pull Confluentinc / CP-Kafka Créer et Start Kafka Container: Docker Run -D --name Kafka -P 9092: 9092 Confluentinc / CP-Kafka Utilisez Docker Logs Kafka pour vérifier les journaux de conteneurs pour vérifier que Kafka est en cours d'exécution. Accédez au panneau de commande Kafka via votre navigateur: http: // localh

2025-04-15

commentaire 0

1172

Création des consommateurs de Kafka avec Reactor Kafka

Présentation de l'article:Cet article détaille la création de consommateurs Kafka évolutifs et résilients à l'aide de Reactor Kafka dans Spring Boot. Il couvre la configuration, le traitement des messages, la gestion de la contre-pression (à l'aide de tampon, onbackpressureRop, etc.), une gestion des erreurs robuste (Retries, D

2025-03-07

commentaire 0

687

Comprendre Kafka Keys: un guide complet

Présentation de l'article:Apache Kafka est une puissante plate-forme de flux d'événements distribué qui est largement utilisée pour créer des pipelines et des applications de données à temps réel. L'une de ses fonctions principales est la clé de message Kafka, qui joue un r?le vital dans les partitions de messages, le tri et le routage. Cet article explore le concept, l'importance et les exemples réels de la clé Kafka.

Qu'est-ce que la clé Kafka?

Dans Kafka, chaque message contient deux composantes principales:

Clé: Déterminez la partition que le message sera envoyé.

Valeur: les données réelles du message sont efficaces.

Les producteurs de Kafka utilisent des clés pour calculer la valeur de hachage, qui détermine la partition spécifique du message. Si la clé n'est pas fournie, le message sera distribué dans chacun de chacun

2025-01-29

commentaire 0

1146

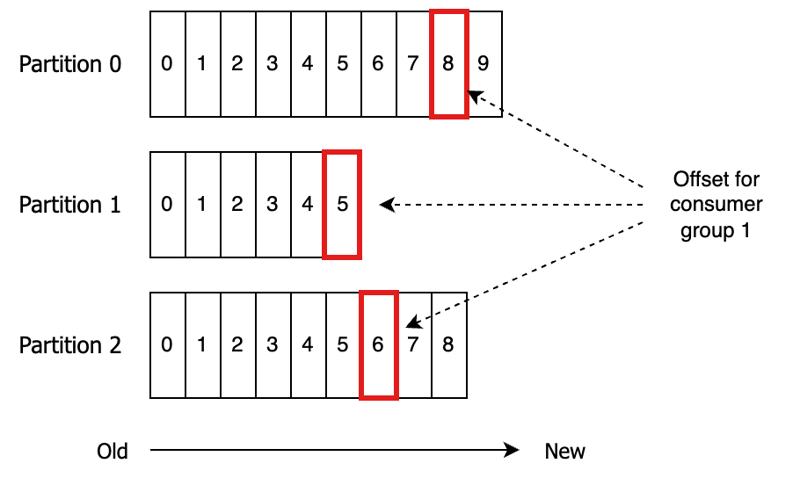

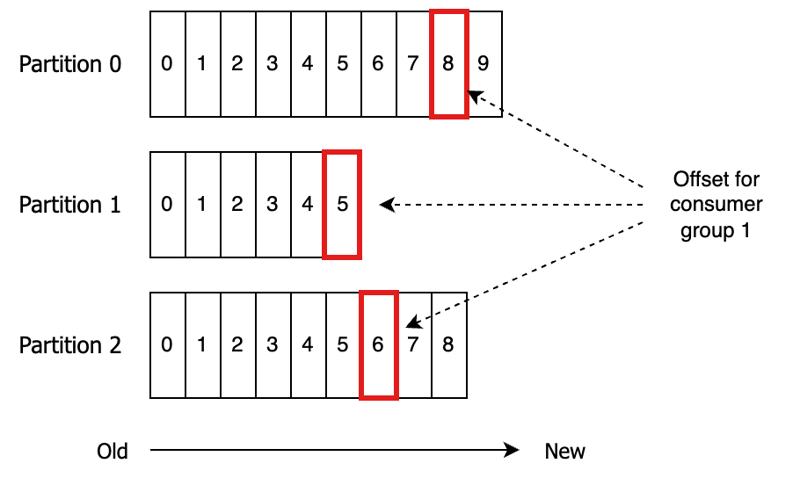

Kafka Consumer - Commissation du groupe de consommateurs décalé

Présentation de l'article:Comprendre les compensations des groupes de consommateurs Kafka?: un guide complet

Ce guide explore les compensations des groupes de consommateurs Kafka, cruciales pour suivre la progression de la consommation des messages. Chaque groupe de consommateurs conserve un décalage pour chaque partition qu'il consomme, indiquant

2025-01-26

commentaire 0

1116

Construire un producteur et un consommateur Kafka en Go

Présentation de l'article:Apache Kafka est une puissante plate-forme de streaming distribuée utilisée pour créer des pipelines de données en temps réel et des applications de streaming. Dans cet article de blog, nous expliquerons la configuration d'un producteur et d'un consommateur Kafka à l'aide de Golang.

Conditions préalables

être

2025-01-03

commentaire 0

999

Travailler avec réactif Kafka Stream et Spring Webflux

Présentation de l'article:Cet article explore la construction d'applications réactives et évolutives axées sur les événements à l'aide de flux réactives Kafka et de Spring Webflux. Il met l'accent sur la manipulation efficace de la contre-pression via les paramètres des consommateurs de Kafka et les opérateurs de réacteurs de projet, et les défenseurs comprennent

2025-03-07

commentaire 0

952

Comment recevoir et consommer des messages livrés et commandés avec Kafka

Présentation de l'article:Pour garantir que les événements sont envoyés et consommés dans un ordre totalement cohérent dans Apache Kafka, il est essentiel de comprendre comment fonctionnent le partitionnement des messages et l'affectation des consommateurs.

Utiliser des partitions dans Kafka

Partition

2024-11-06

commentaire 0

500

Accélérez GenAI?: diffusez des données de MySQL vers?Kafka

Présentation de l'article:à l’ère de l’IA, Apache Kafka devient une force incontournable en raison de ses hautes performances en matière de streaming et de traitement des données en temps réel. De nombreuses organisations cherchent à intégrer des données à Kafka pour améliorer leur efficacité et leur agilité commerciale. Dans ce cas

2024-11-03

commentaire 0

340

Révolutionner les pipelines de données avec Apache Kafka en 2025

Présentation de l'article:Cet article examine le r?le d'Apache Kafka dans l'architecture des pipelines de données d'ici 2025. Il traite des défis tels que l'explosion des volumes de données, les demandes d'analyse en temps réel et les sources de données complexes. L'article met en évidence l'évolutivité de Kafka, Capab en temps réel

2025-03-07

commentaire 0

504

RabbitMQ vs Kafka?: choisir le bon courtier de messages pour votre application Java

Présentation de l'article:Comparaison de RabbitMQ et Kafka?:

Lorsque vous décidez entre RabbitMQ et Kafka pour vos besoins en matière de courtage de messages, il est essentiel de comprendre leurs atouts uniques et leurs meilleurs cas d'utilisation.

RabbitMQ est un courtier de messages traditionnel qui utilise un modèle push pour traiter

2024-11-12

commentaire 0

648

Options de reconnaissance du message Kafka

Présentation de l'article:Cet article examine les options de reconnaissance du message de Kafka: automatique, synchrone manuelle, manuelle asynchrone et manuelle avec des décalages spécifiques. Il analyse leurs compromis de performance entre le débit et la fiabilité, guidant les lecteurs à SELE

2025-03-07

commentaire 0

697

Comment se connecter et utiliser Kafka avec une application Go?

Présentation de l'article:Les étapes clés pour se connecter avec GO et l'utilisation de Kafka incluent l'installation de la bibliothèque Kafka-Go, la rédaction de producteurs pour envoyer des messages, la rédaction de consommateurs pour recevoir des messages et faire attention aux problèmes communs. 1. Installez la bibliothèque Kafka-Go pour gérer les dépendances via Gomod; 2. Créez le producteur pour envoyer des messages au sujet spécifié à l'aide de l'écrivain; 3. Créez le consommateur pour utiliser le lecteur pour retirer les messages du sujet spécifié; 4. Faites attention à des détails tels que l'adresse du courtier, le nom du sujet, les paramètres de groupe de consommateurs et le réglage des performances.

2025-07-17

commentaire 0

113

Guide pratique du protocole Kafka

Présentation de l'article:J'ai beaucoup travaillé avec le protocole Apache Kafka au bas niveau. Ce n'était pas facile de commencer à faire cela en suivant uniquement le guide officiel et j'ai beaucoup lu le code. Avec cet article, je souhaite vous donner une longueur d'avance en vous guidant étape par étape depuis le début.

2024-12-28

commentaire 0

586

Assurer la métamorphose?: analyse du projet Kafka

Présentation de l'article:Vous êtes-vous déjà demandé quels bugs pourraient se cacher dans le code source des projets des entreprises mondiales?? Ne manquez pas l'occasion de repérer des bugs intéressants détectés par l'analyseur statique PVS-Studio dans le projet open source Apache Kafka.

Présenter

2024-10-16

commentaire 0

744